前言

近日AI大模型的排名又又又刷新了,阿里通义千问正式发布了Qwen3大语言模型,在预训练方面,Qwen3的数据集相比Qwen2.5在token数量上高出了两倍!约有36万亿个token,涵盖119种语言和方言。并且在预训练过程中通过增加知识密集型数据的比例来改进数据集,使用高质量的上下文数据将上下文长度扩展至32000个token,以确保模型能有效处理更长的输入。

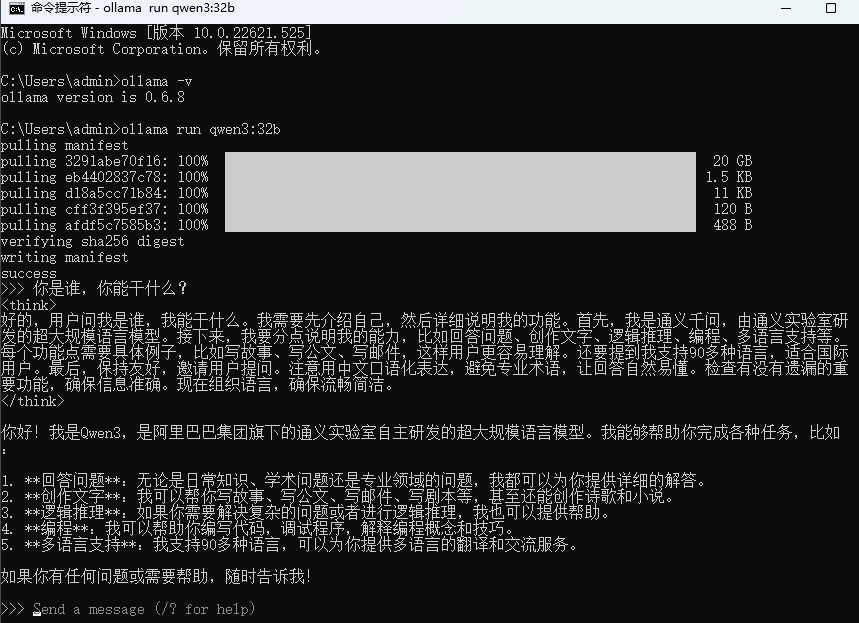

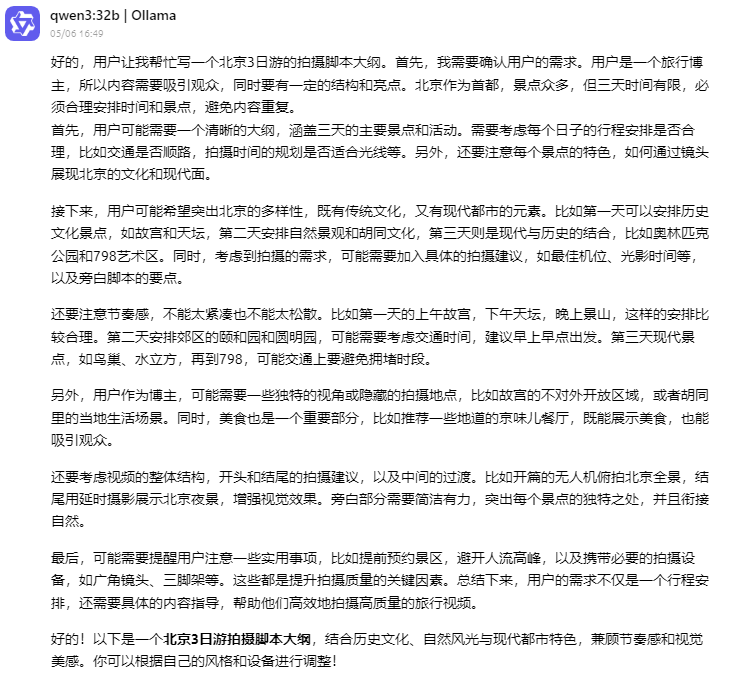

在本地实机部署了qwen3:32b模型并进行对话后,了解到它可以帮助我们解答各种问题、提供信息、创作文字(如写故事、写公文、写邮件、写剧本等)、编程、进行逻辑推理、表达观点,甚至玩游戏。而训练数据截止时间是2024年10月,它会以这一时间点为基础来提供信息和回答问题。

接下来本文将详细介绍如何在Windows系统电脑本地部署Qwen3-32B模型,使用Cherry Studio接入模型并结合cpolar内网穿透工具实现随时随地远程调用本地部署的大模型,过程非常简单,而且无需公网IP,也不用准备云服务器那么麻烦。

1.安装Ollama

本例中使用的是Windows11系统专业版,32G内存条,12G的3060显卡,通过Ollama运行Qwen3:32B大模型,之前曾经发布过如何在Windows安装Ollama的教程,有需要的同学可以看看这篇文章:Windows本地部署Deepseek-R1大模型并使用Web界面远程交互

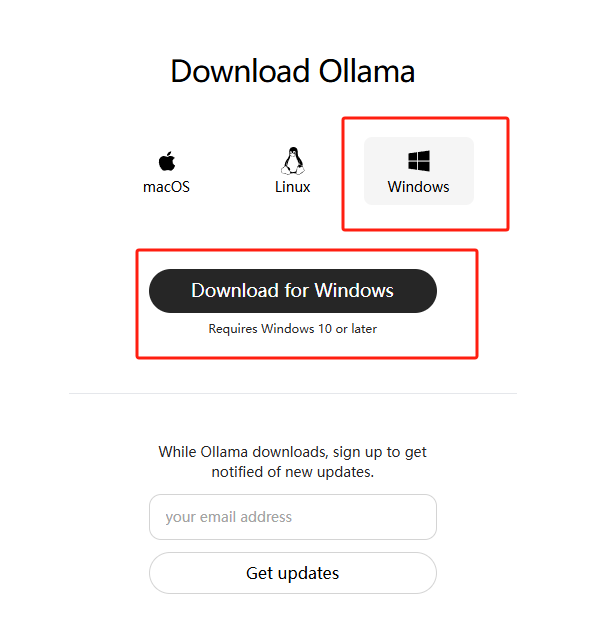

简单来说,就是访问Ollama的官网:Download Ollama on Windows 下载对应版本的ollama安装程序并安装:

2.Qwen3:32B模型安装与运行

然后在Ollama的官网点击Models,可以看到Qwen3模型:

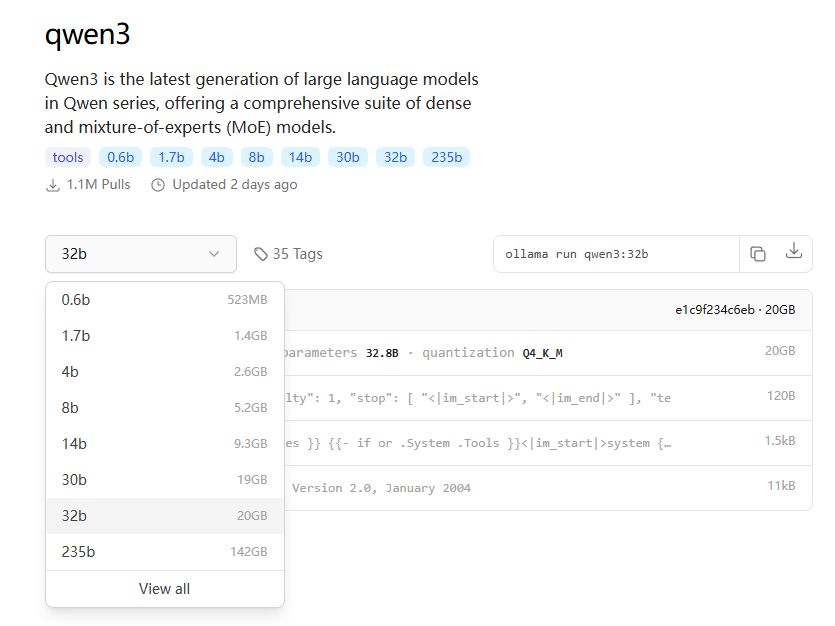

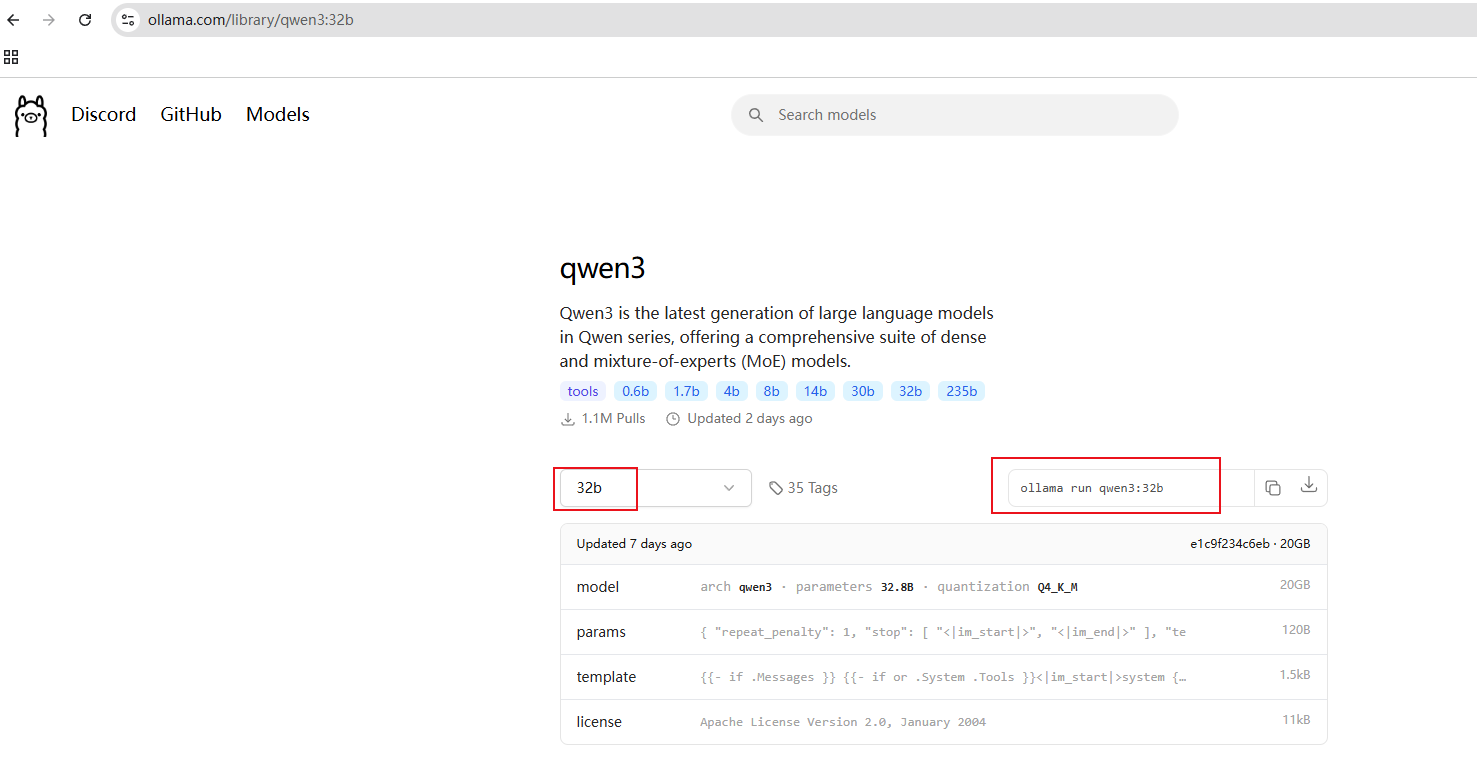

点进去之后,在左侧的下拉选项中能看到多个不同量级的模型,本文以32b模型进行演示:

下载该模型需要准备20G以上硬盘空间,右边是运行命令。

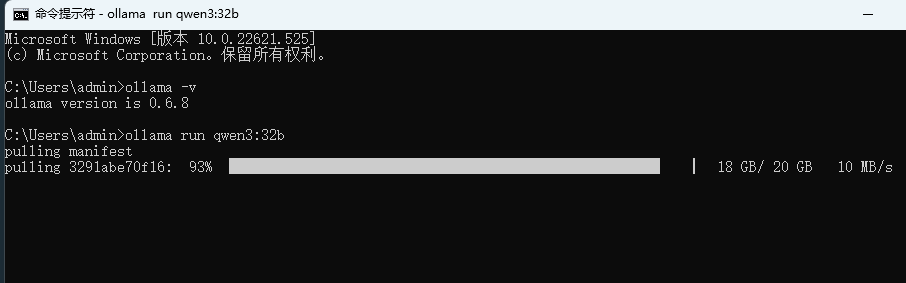

Ollama安装完成之后,打开cmd或者powershell等终端工具,执行这个命令就可以下载模型了:

ollama run qwen3:32b

PS:默认会下载模型到C盘,如果想修改下载位置,可以在终端中执行下方命令来指定模型文件的存放目录,这里以d:\ollama为例,大家可以自定义:

set OLLAMA_MODELS=d:\ollama

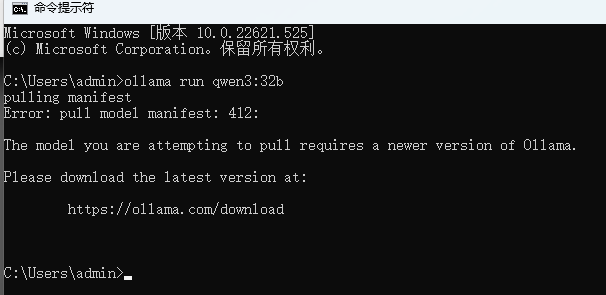

如果你之前安装过ollama,在执行命令后出现如下图提示,那么关闭终端,请先升级ollama到最新版本。

更新后(本例ollama版本为0.6.8),即可正常下载:

看到Success提示直接输入内容就能提问了:

3. 安装Cherry Studio客户端

现在我们已经能够在本地Windows电脑上使用Qwen3:32B模型解答问题了,但在命令行中对话可能不是很美观,在复制回答与进行其他功能配置时也不太方便,我们可以通过安装一个图形化界面或客户端来解决这个问题。

本例以Cherry Studio这个AI客户端为例,安装后就能像在网页中一样和AI聊天了。当然,大家也可以选择其他的方式,比如使用page assist浏览器插件,lobechat等。

3.1 下载客户端

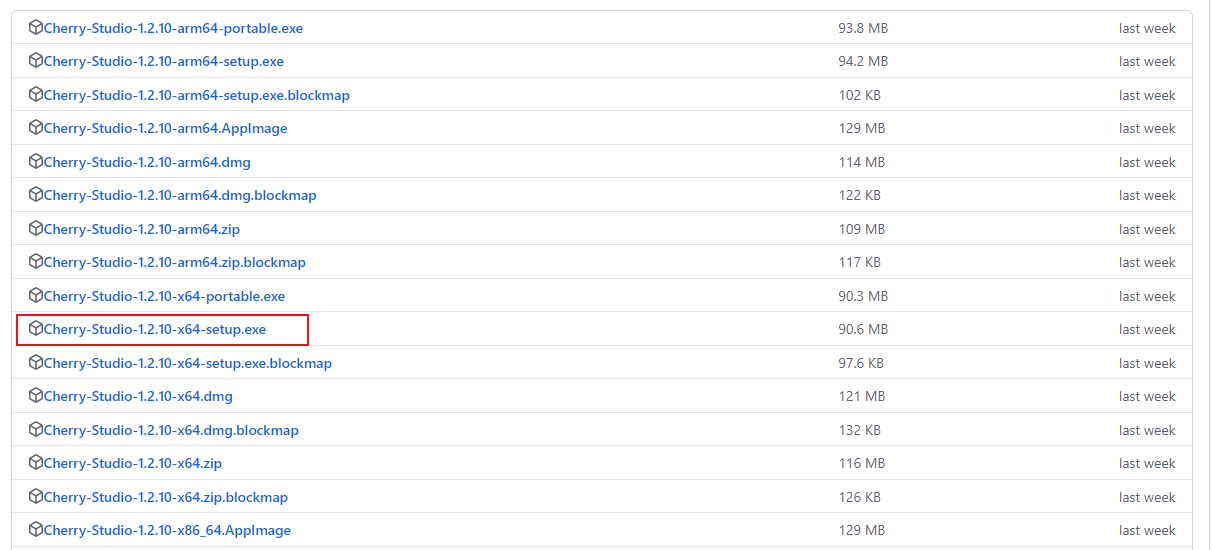

首先,我们访问Cherry Studio的github主页下载客户端:https://github.com/CherryHQ/cherry-studio/releases

找到Windows版本客户端安装程序下载即可:

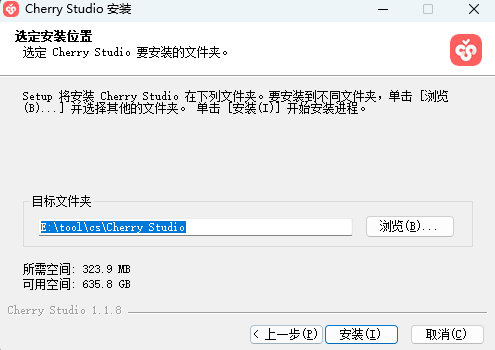

选择好安装位置后,即可快速安装:

3.2 配置本地模型

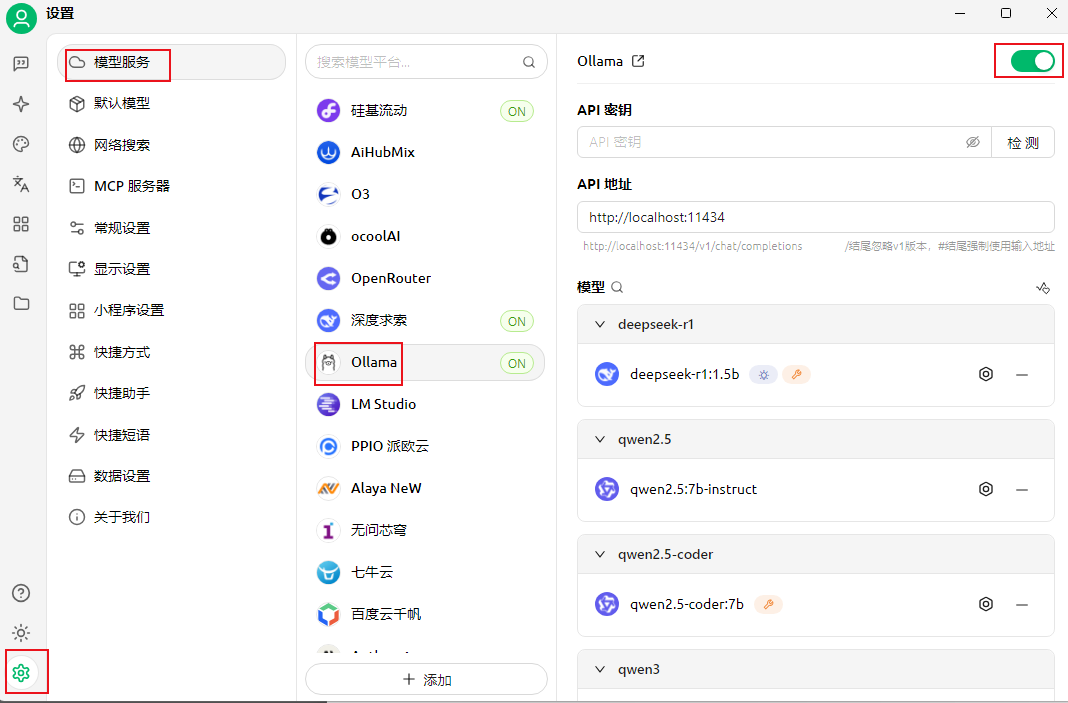

打开客户端后,点击左下角的设置,即可进行模型服务配置:

首先模型服务中选择Ollama,打开右上角的开关:

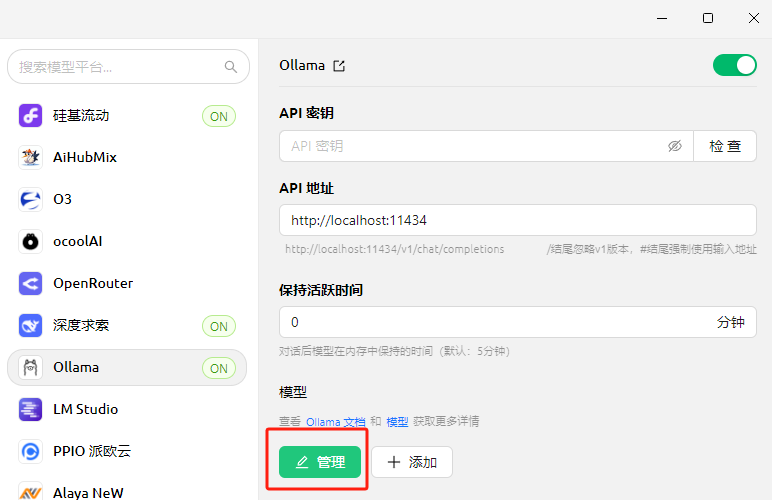

点击管理:

在这里可以看到我们之前在本地已经下载好的Qwen3-32b模型,点击加号添加即可:

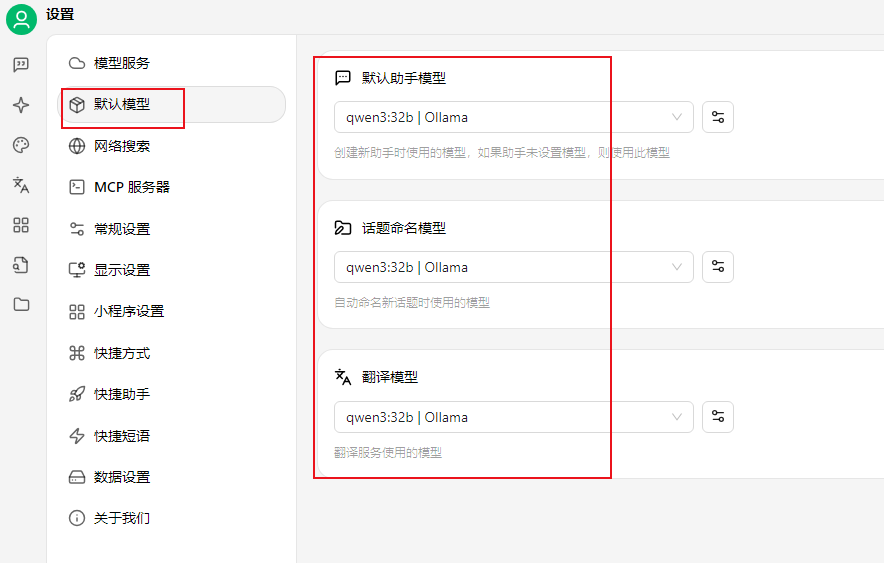

然后在模型服务下面的默认模型中,可以将默认助手,话题命名,翻译模型都改为qwen3:32b方便后续使用。

3.3 本地对话测试

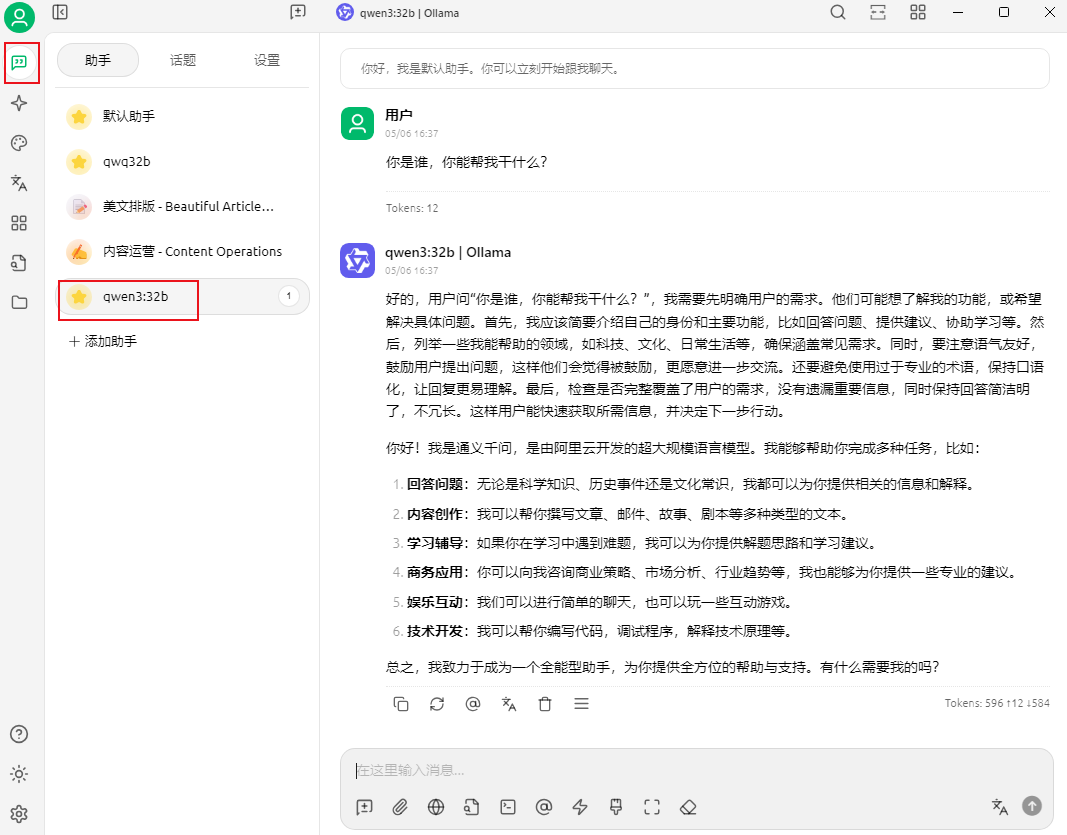

现在,我们点击Cherry Studio右侧菜单创建一个新的聊天助手,即可在聊天框中向qwen3模型提问了:

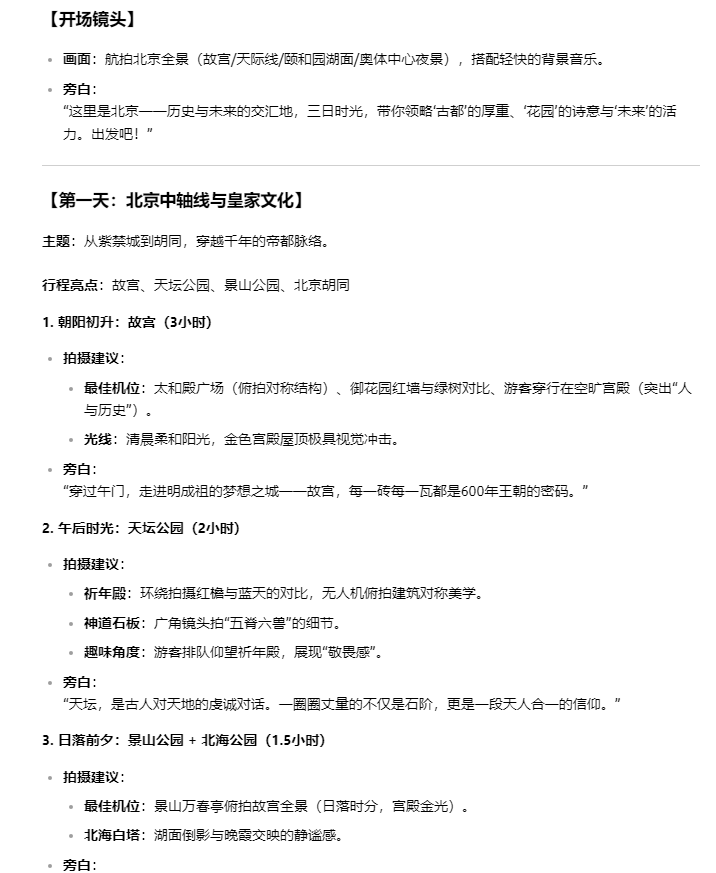

首先测试一下给出身份要求后,让AI帮我写一个视频拍摄的脚本大纲看看效果如何:

首先是分析过程:

接着是回答:

可以看到,给出了开场,旁白,主题,行程亮点,拍摄建议等多个结果,还是挺完整的。

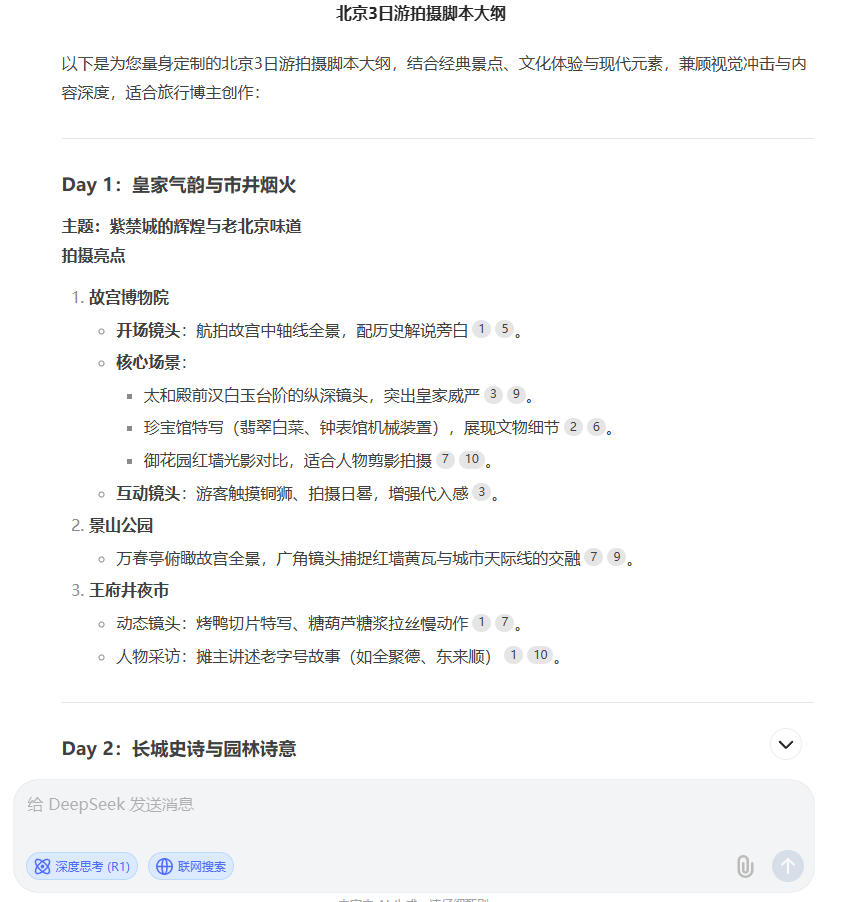

同样的问题,下面是向deepseek-r1的提问,大家可以简单对比一下:

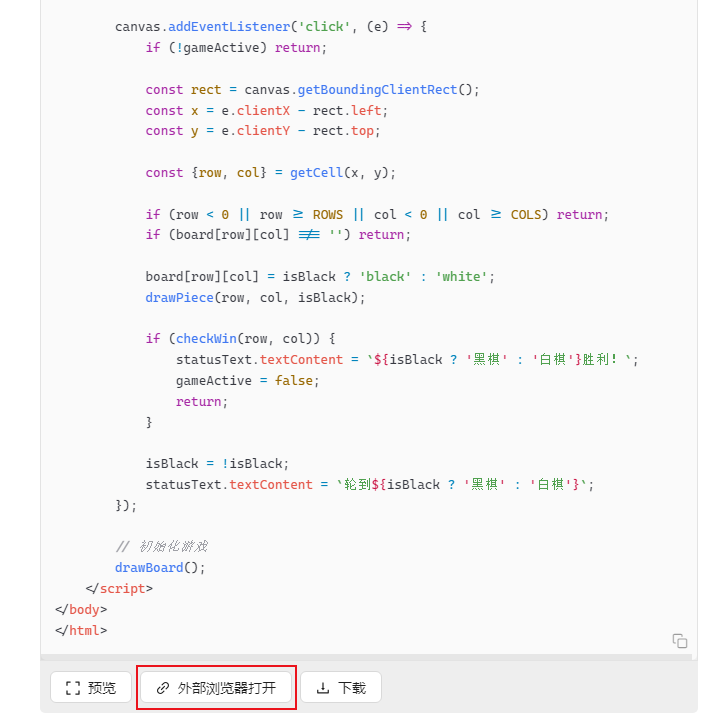

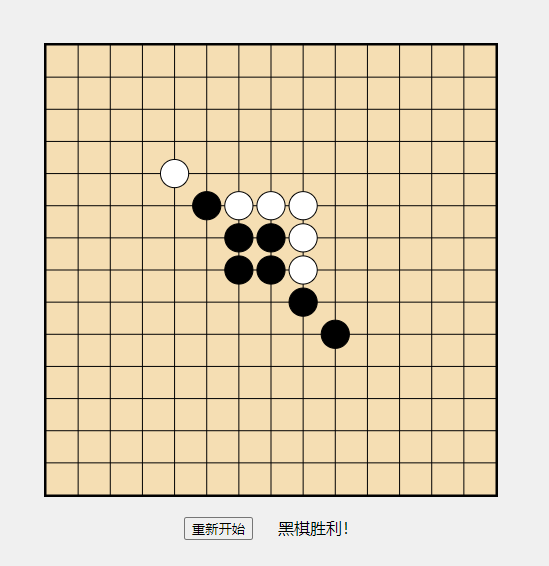

下面再让它帮我写一个五子棋网页小游戏测试一下效果如何:

效果不错,直接浏览器打开就可以玩,鼠标左键单击即可轮流下子,还有重新开始按钮。

经过简单测试感觉qwen3能力确实还行,大家感兴趣的话也可以稍后自己部署一下进行测试。

4. 安装内网穿透工具

现在我们已经在本地成功部署了qwen3模型,并通过Cherry Studio在图形化界面中和AI聊天了,但如果我们部署的这台电脑配置不错,使用这款大模型毫无压力,要是我们出门时,或者是想团队多人使用,打算远程调用这台电脑上部署的大模型应该怎么办呢?

其实很简单,我们只需要在部署了大模型的设备中安装Cpolar内网穿透工具就能轻松实现公网环境远程访问了!通过它,我们可以免去复杂得本地二次部署过程,只需要一个公网地址就可以随时随地访问已经部署过qwen3大模型的设备来使用AI。无需自己注册域名或准备云服务器那么麻烦。

首先需要进行对ollama进行一下环境变量设置,这是之后我们远程调用本地大模型的前提:

打开cmd终端,执行下面两个命令:

setx OLLAMA_HOST "0.0.0.0"

setx OLLAMA_ORIGINS "*"

然后安装cpolar内网穿透工具:

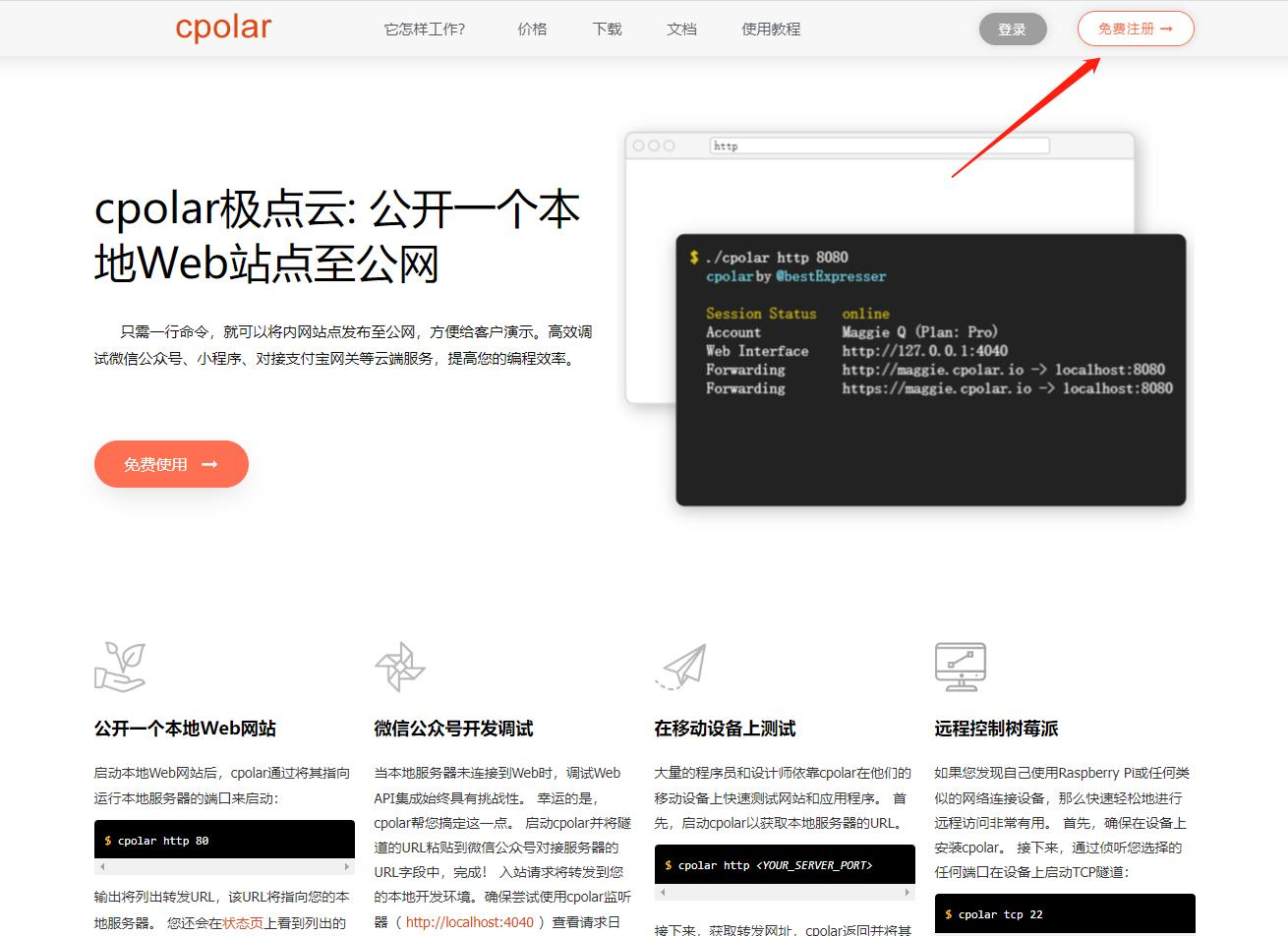

访问cpolar官网: https://www.cpolar.com 点击免费使用注册一个账号,并下载最新版本的Cpolar。

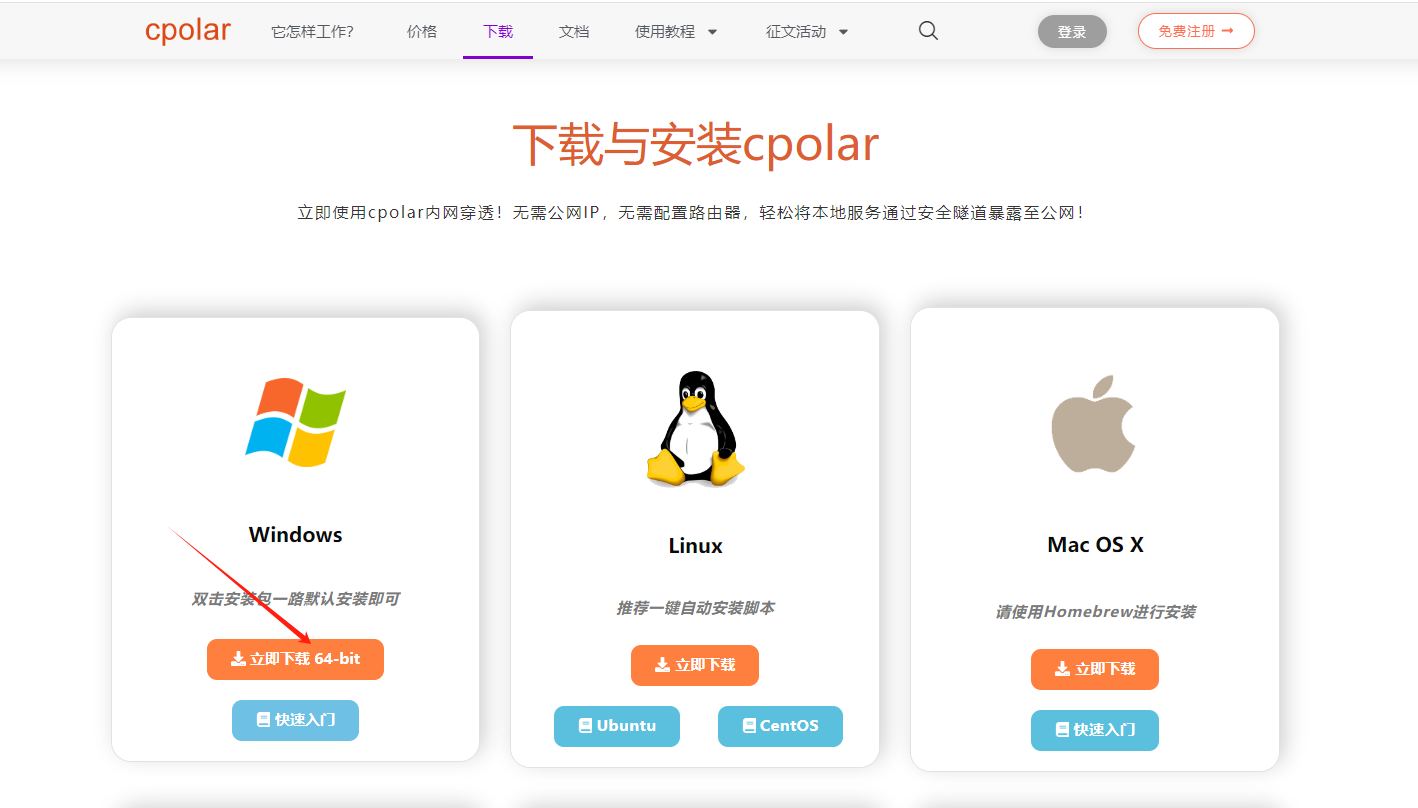

登录成功后,点击下载Cpolar到本地并安装(一路默认安装即可)本教程选择下载Windows版本。

Cpolar安装成功后,在浏览器上访问http://localhost:9200,使用cpolar账号登录,登录后即可看到Cpolar web 配置界面,结下来在web 管理界面配置即可。

4.1 创建远程连接公网地址

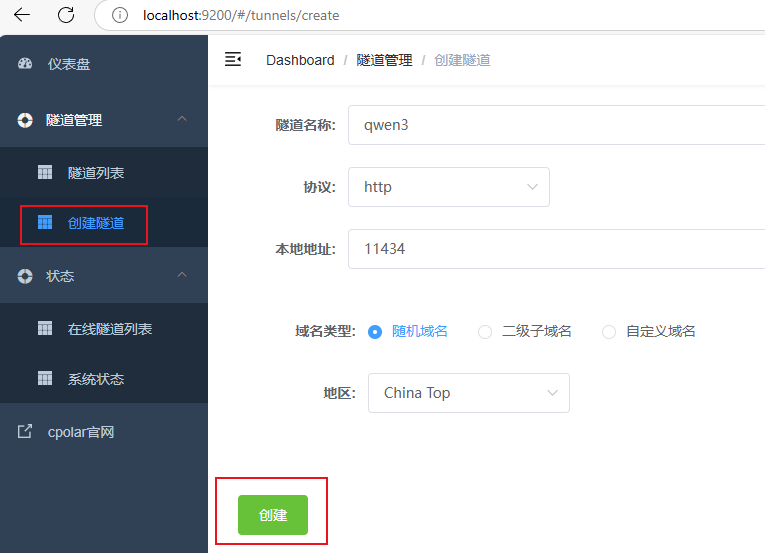

登录cpolar web UI管理界面后,点击左侧仪表盘的隧道管理——创建隧道:

- 隧道名称:可自定义,本例使用了: qwen3 注意不要与已有的隧道名称重复

- 协议:http

- 本地地址:11434

- 域名类型:随机域名

- 地区:选择China Top

点击保存

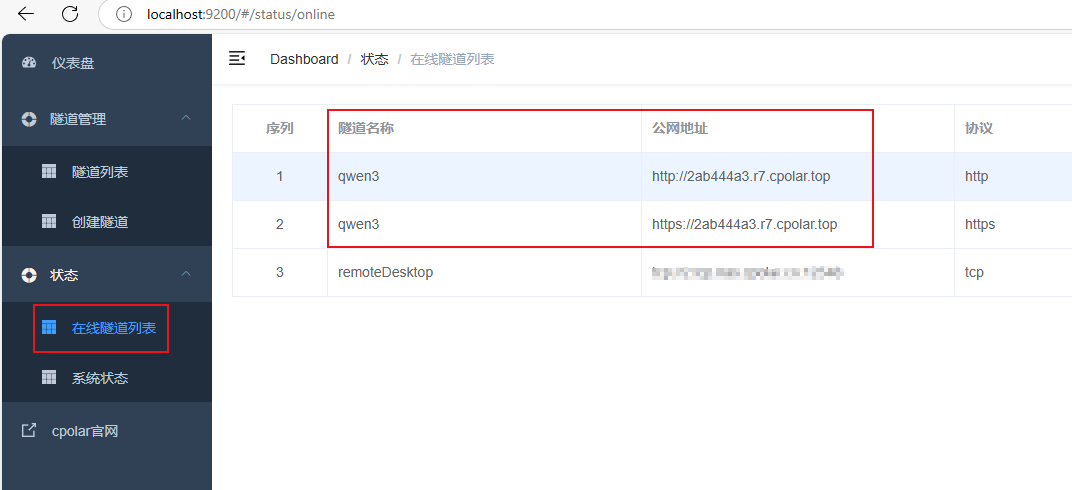

隧道创建成功后,点击左侧的状态——在线隧道列表,查看所生成的公网访问地址,有两种访问方式,一种是http 和https:

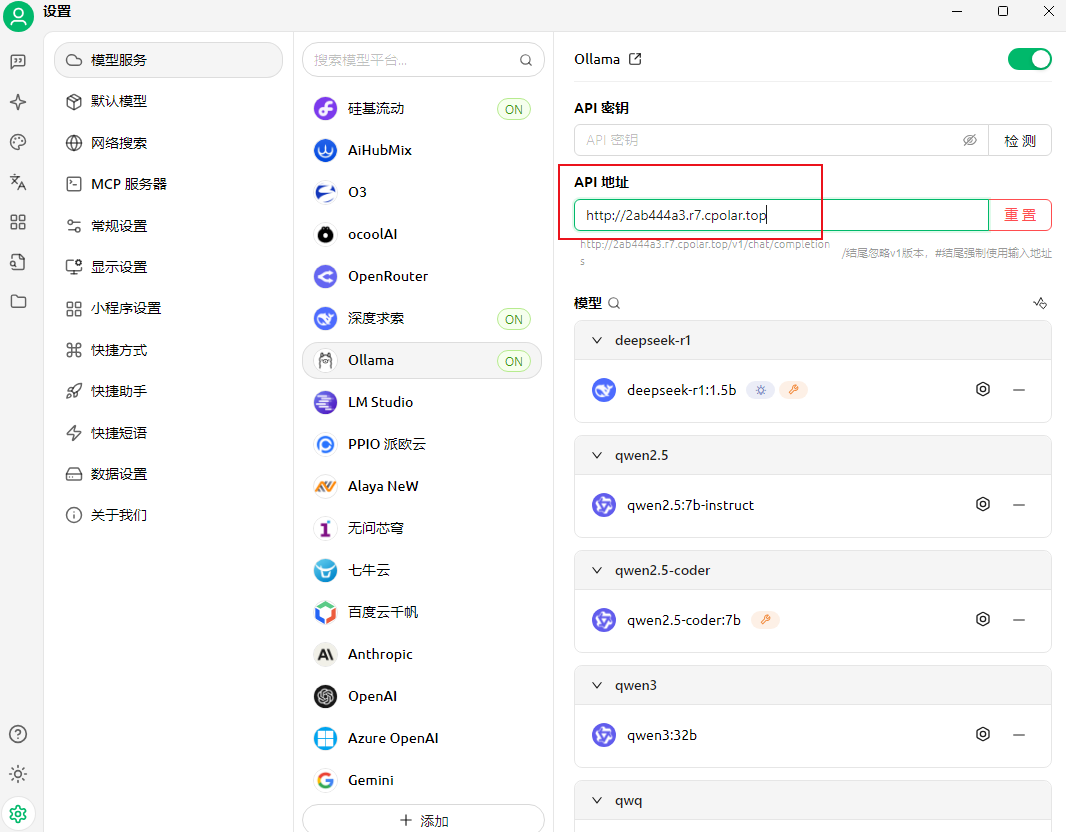

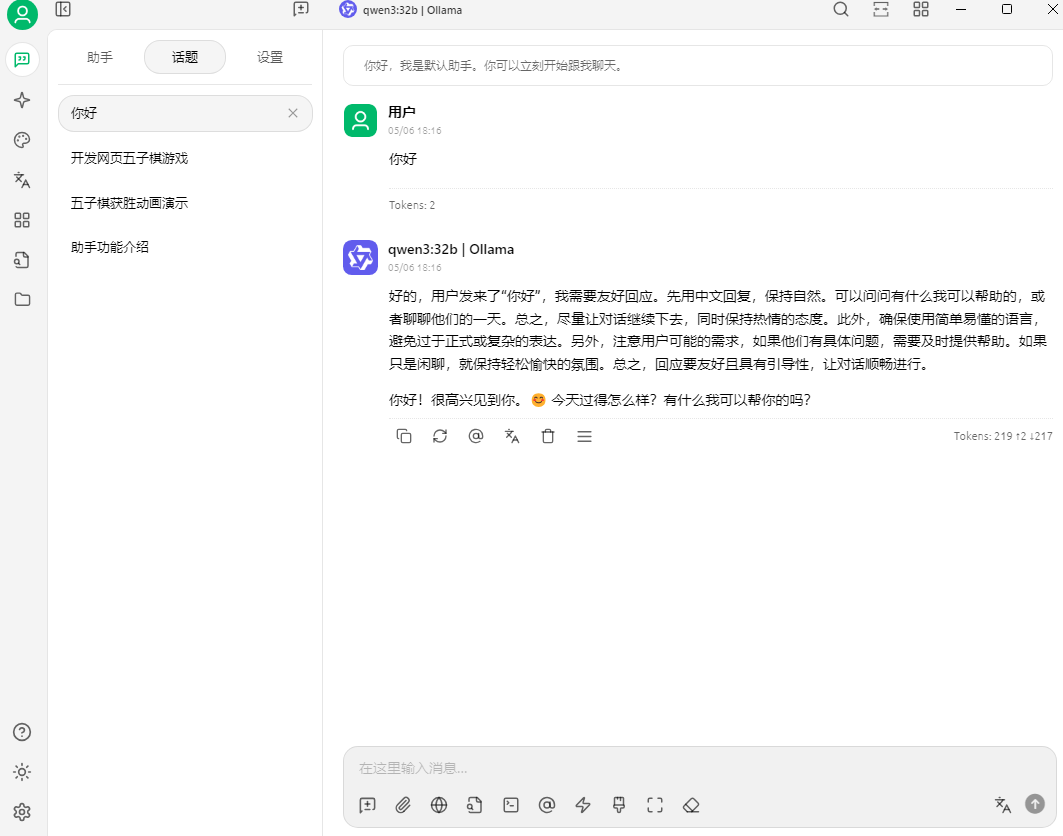

现在无论你在哪里,使用上面的任意一个公网地址,粘贴到Cherry Studio客户端的ollama模型服务的API地址里:

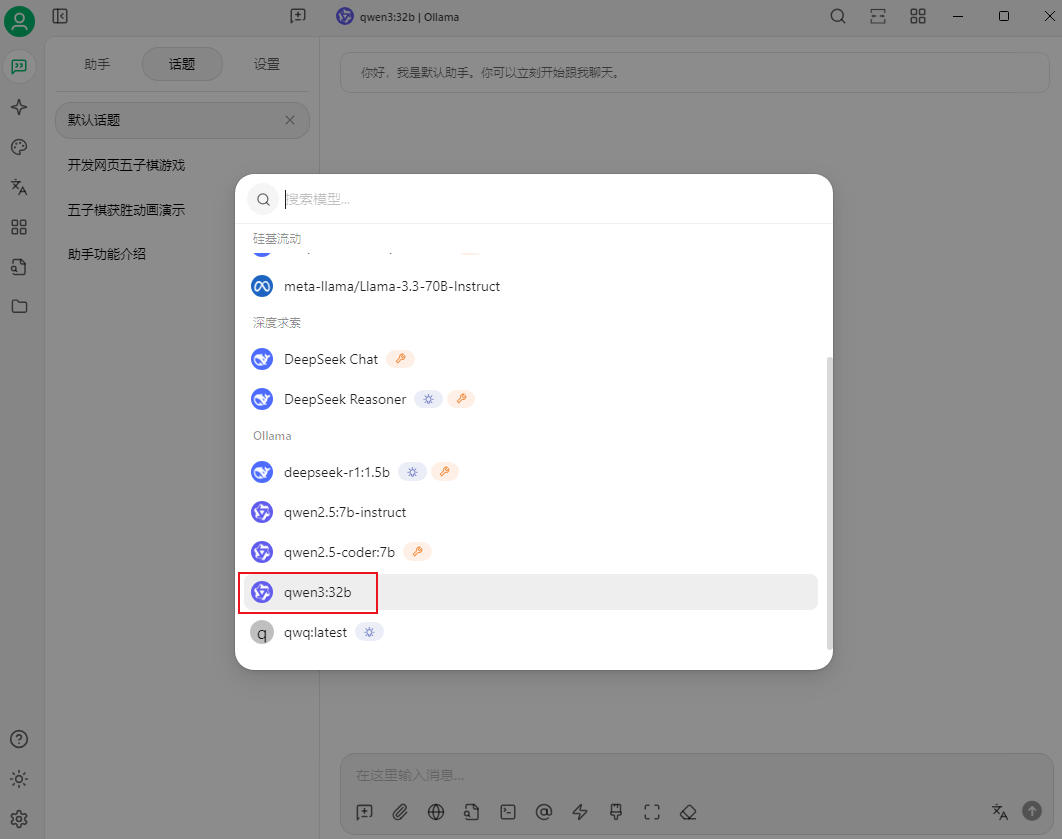

点击管理,也能看到在本地部署的qwen3-32b模型,并将它添加到你现在使用的Cherry Studio客户端中!

点击添加,即可在公网环境使用其他电脑随时随地远程调用本地内网大模型:

小结

为了方便演示,我们在上边的操作过程中使用cpolar生成的HTTP公网地址隧道,其公网地址是随机生成的。这种随机地址的优势在于建立速度快,可以立即使用。然而,它的缺点是网址是随机生成,这个地址在24小时内会发生随机变化,更适合于临时使用。

如果有长期远程使用Cherry Studio远程调用本地AI大模型,或者异地访问与使用其他本地部署的服务的需求,但又不想每天重新配置公网地址,还想让公网地址好看又好记并体验更多功能与更快的带宽,那我推荐大家选择使用固定的二级子域名方式来为本地服务配置一个公网地址。

5. 配置固定公网地址

接下来演示如何为本地ollama配置固定的HTTP公网地址,该地址不会变化,方便分享给别人长期查看你部署的项目,而无需每天重复修改服务器地址。

配置固定http端口地址需要将cpolar升级到专业版套餐或以上。

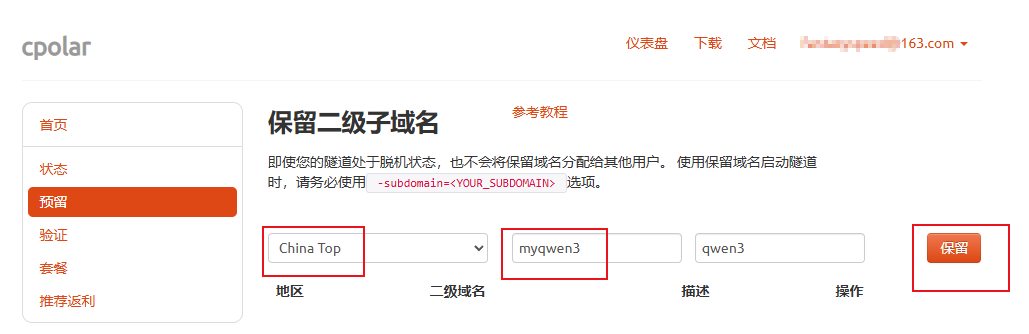

登录cpolar官网,点击左侧的预留,选择保留二级子域名,设置一个二级子域名名称,点击保留:

保留成功后复制保留成功的二级子域名的名称:myqwen3,大家也可以设置自己喜欢的名称。

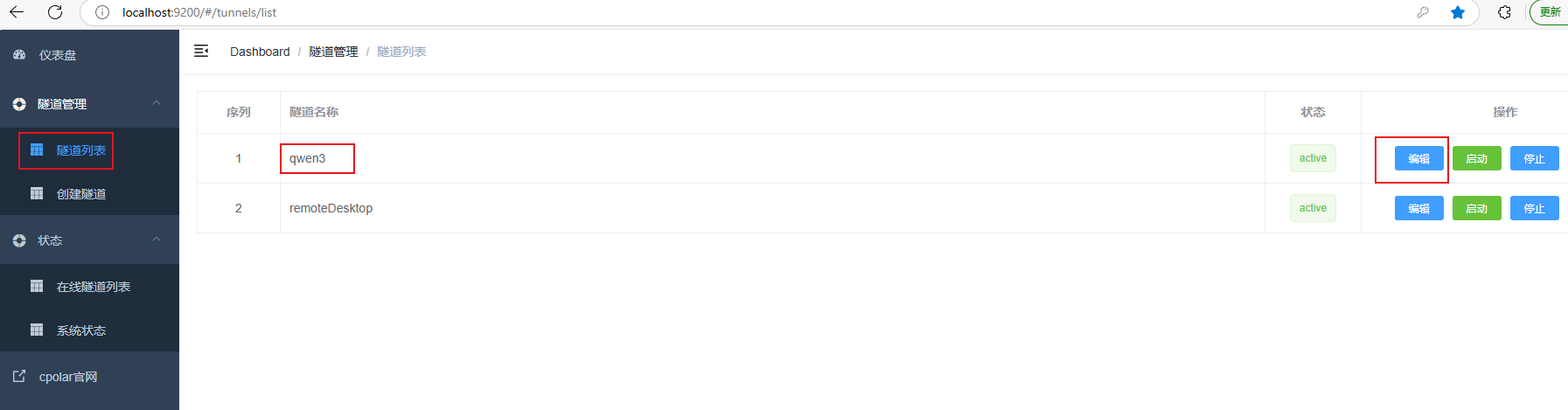

返回Cpolar web UI管理界面,点击左侧仪表盘的隧道管理——隧道列表,找到所要配置的隧道:qwen3,点击右侧的编辑:

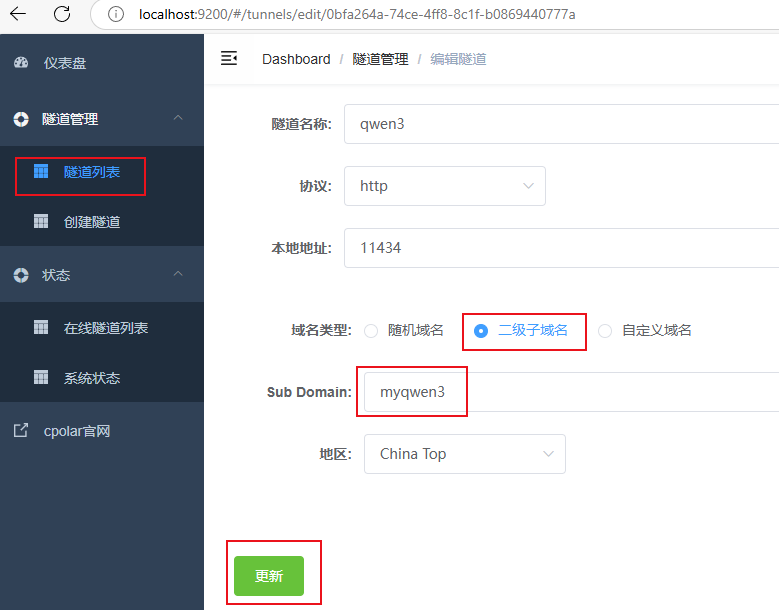

修改隧道信息,将保留成功的二级子域名配置到隧道中

- 域名类型:选择二级子域名

- Sub Domain:填写保留成功的二级子域名:

myqwen3

点击更新(注意,点击一次更新即可,不需要重复提交)

更新完成后,打开在线隧道列表,此时可以看到公网地址已经发生变化,地址名称也变成了固定的二级子域名名称的域名:

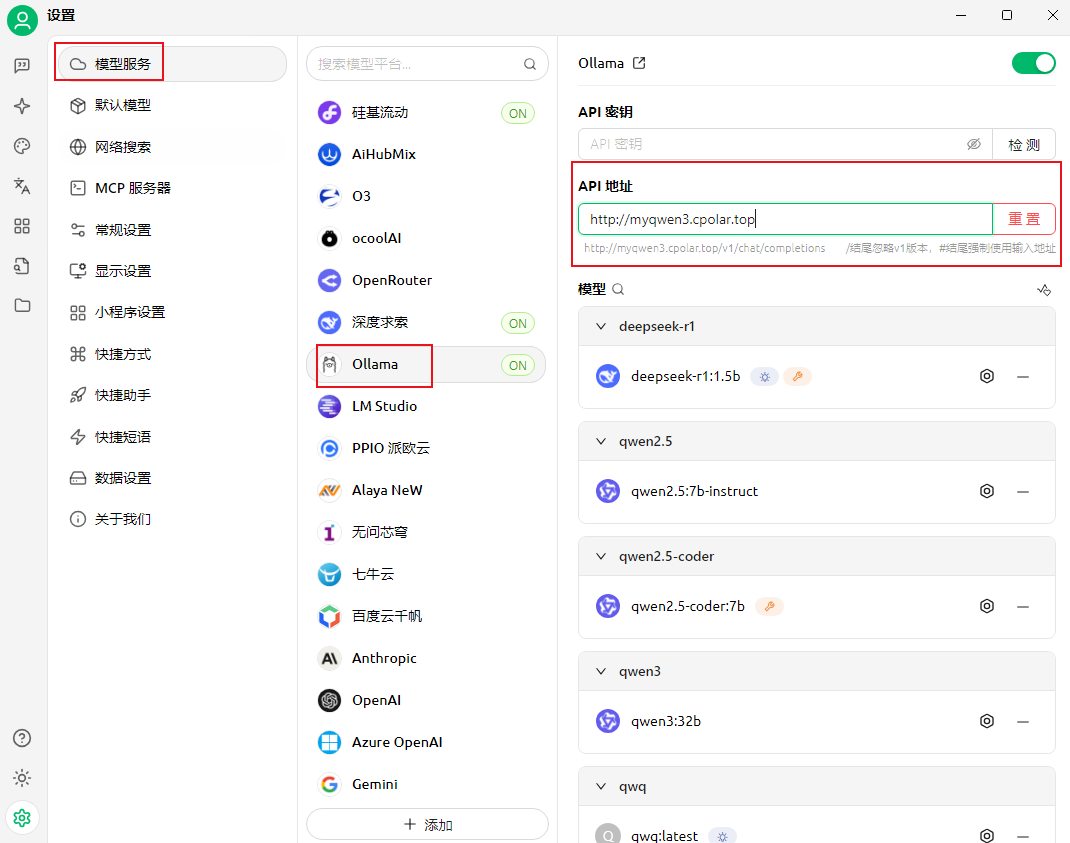

最后,我们使用上面的任意一个固定公网地址,粘贴到Cherry Studio客户端的ollama模型服务的API地址里:

返回聊天助手界面,同样能看到在本地部署的qwen3-32b模型,添加后即可正常聊天,无需每天更换公网地址。

总结

通过以上步骤,我们实现了在Windows系统电脑本地安装Cherry Studio客户端并配置Qwen3:32B开源AI大模型服务,并使用cpolar内网穿透工具轻松实现在公网环境中也能使用Cherry Studio远程访问本地部署的大模型,并为本地服务配置固定不变的二级子域名公网地址的全部流程。

经过简单测试,Qwen3大模型的能力确实很惊艳,支持的功能也非常多,而结合内网穿透使用则降低了使用门槛,无需二次部署,提高效率。另外,Cherry Studio针对个人用户免费,企业用户请联系官方合作。作为AI爱好者非常期待这些优秀的AI产品的后续发展,也感谢您的观看,有任何问题欢迎留言交流。