前言

你是否曾兴奋地在本地部署了Ollama,却很快被冰冷的命令行和繁琐的指令劝退?是否羡慕ChatGPT那样优雅的聊天界面,却又希望数据能牢牢掌握在自己手中?

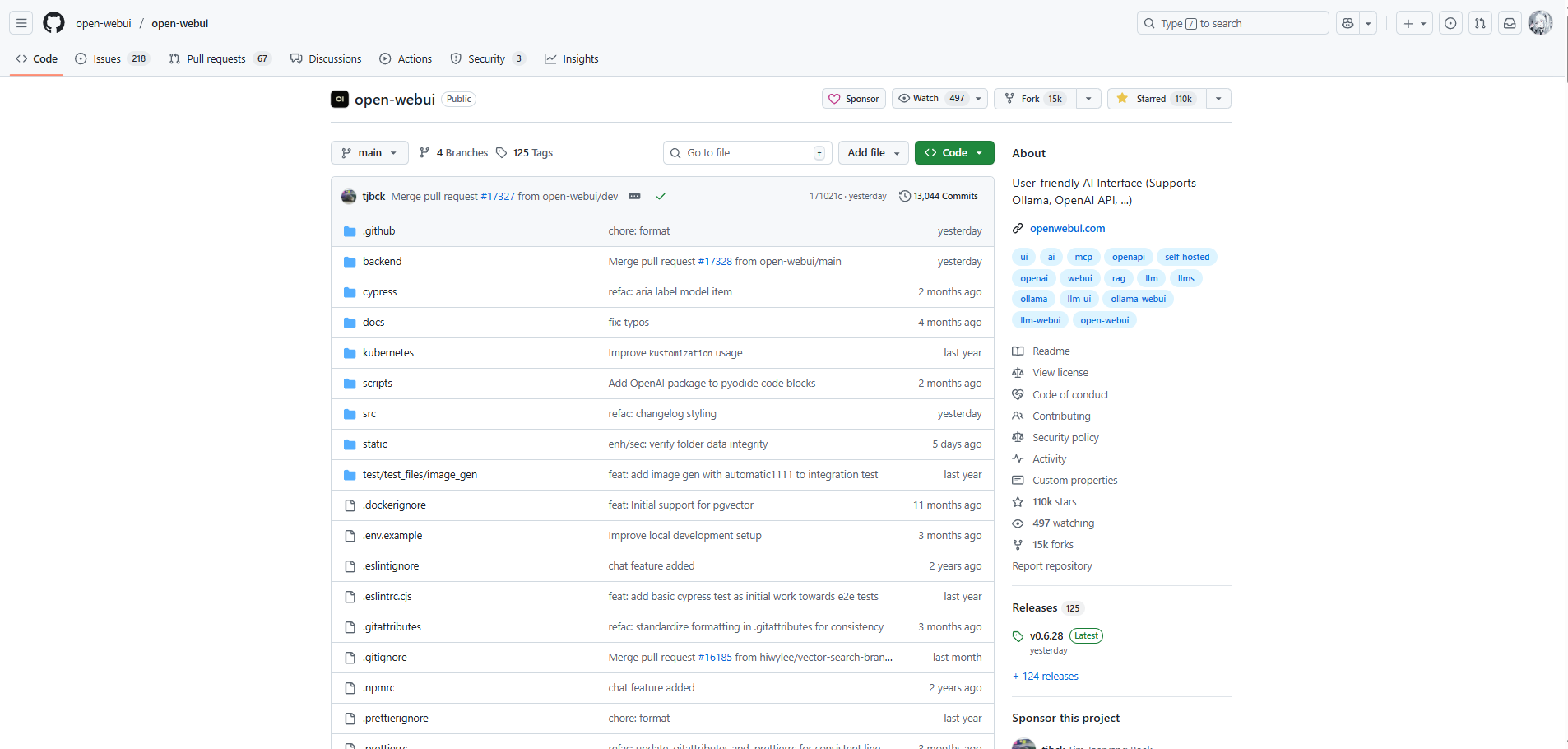

你的烦恼,全球的开发者都感同身受。而今天,这个困扰迎来了它的“终极答案”——OpenWebUI。这个在GitHub上狂揽 110,000 Stars 的明星项目,完美地解决了所有痛点。它不是一个简单的聊天框,而是一个功能强大的可视化控制台,让你能像管理公司项目一样,轻松驾驭本地的AI模型。

本文将带你一步步部署OpenWebUI,并将当前炙手可热的DeepSeek R1模型无缝接入其中。最终,你将获得一个:

✅ 拥有惊艳交互界面的私人 AI 助手 – 提供类似 ChatGPT 的流畅体验,支持 Markdown、LaTeX 渲染、对话历史管理和多主题切换

✅ 支持多模型快速切换的管理中心 – 同时管理 Ollama 本地模型和 OpenAI 兼容 API(如 DeepSeek R1),一键切换不同模型

✅ 内置 MCP(模型上下文协议)支持的智能代理 – 让 AI 不仅能回答问题,还能通过标准化协议操作工具、访问外部数据和服务,实现真正的”能动性”

✅ 具备高级 RAG 能力的知识库系统 – 支持本地文档上传与智能检索,构建专属知识库

✅ 无需公网 IP、通过安全内网穿透实现全球远程访问的智能平台 – 随时随地安全访问你的私有 AI 环境

✅ 企业级多用户管理与权限控制 – 支持团队协作和用户角色分配,满足商业部署需求

✅ 完全开源、自主可控的私有化解决方案 – 所有数据留在本地,绝无云端隐私风险

1 OpenWebUI介绍及演示

1.1 OpenWebUI界面操作演示

在深入任何技术细节之前,让我们先看看你将通过本教程搭建完成的终极工作台。这将彻底改变你与本地大模型交互的方式。

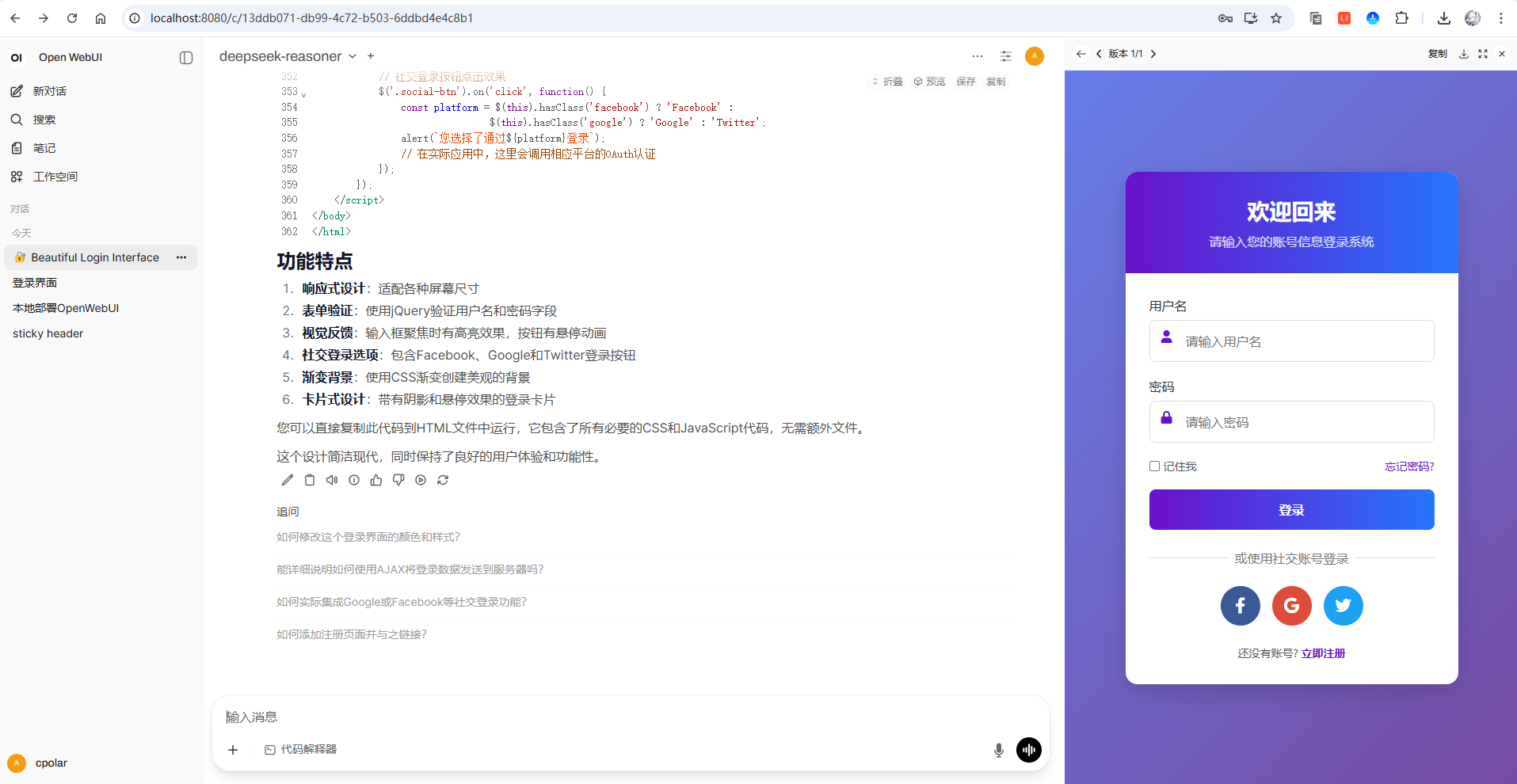

open webui效果图(支持预览代码):

GIF动图演示(生成一个html登录界面):

怎么样,是不是效果特别棒,有没有兴趣一起搭建本地部署一个体验一下!

1.2 OpenWebUI介绍

OpenWebUI(原名 Ollama WebUI)不仅仅是一个为 Ollama 打造的聊天界面,更是一个功能丰富的开源 Web 用户界面与管理平台。它的核心使命是让每个人都能以最简单、最直观的方式,与运行在本地或私有环境中的大语言模型进行交互和管理,同时提供企业级的功能扩展性。

项目地址:https://github.com/open-webui/open-webui

为什么 OpenWebUI 能获得全球开发者青睐?

OpenWebUI 之所以能够迅速赢得 110K Stars,源于它完美结合了强大功能与极致易用性,成为一个真正全面的 AI 管理与应用控制台。

核心优势:

- 极致的用户友好体验

提供媲美 ChatGPT 的交互体验,支持流畅的打字机效果、完整的 Markdown 渲染(含表格和 LaTeX 数学公式)、代码高亮与复制功能、多主题切换以及完整的对话历史管理。用户无需记忆复杂的 Ollama 命令行指令,所有操作均可通过直观的界面完成。

- 强大的多功能集成与扩展能力

- 多模型生命周期管理:支持 Ollama 全系列本地模型,同时可连接 OpenAI 兼容 API(如 DeepSeek R1)、Claude 系列、LocalAI 等多种后端,成为统一的模型控制中心

- 检索增强生成(RAG)与知识库:内置强大的 RAG 引擎,支持上传 PDF、DOCX、TXT 等多种格式的本地文档,构建专属知识库

- 工具调用与 MCP 兼容性:支持模型调用外部工具执行复杂任务,展现了与模型上下文协议类似的强大能力

- 提示词工作流与协作:提供提示词市场和管理功能,支持创建、保存、共享和重用自定义提示词模板

-

隐私安全与灵活部署

所有数据完全运行在本地环境或私有服务器上,确保百分百离线与绝对隐私。支持多种部署方式,极大降低使用门槛。

- 无缝的 Ollama 集成

自动检测本地运行的 Ollama 服务及已下载的模型,开箱即用,无需复杂配置。作为完全开源的项目,拥有高度可定制性和活跃的社区支持。

核心功能概览

| 功能模块 | 核心能力 | 价值 |

|---|---|---|

| 模型管理 | 多后端支持、模型下载/切换/加载、参数实时调整 | 统一管理入口,灵活适配不同场景 |

| 交互体验 | 类 ChatGPT 界面、代码高亮、Markdown 渲染、多会话管理 | 降低使用门槛,提供流畅体验 |

| 知识管理 | 文档上传、知识库构建、语义搜索、上下文增强 | 利用私有数据提升回答准确性 |

| 高级功能 | 工具调用、Web 搜索集成、提示词工作流、多模态支持 | 扩展模型能力边界,实现任务自动化 |

| 用户管理 | 多用户系统、角色权限控制、团队协作 | 满足企业级部署需求,保障数据安全 |

| 部署隐私 | 完全离线、自托管、Docker 容器化、数据本地存储 | 彻底掌控数据,保障隐私安全 |

OpenWebUI 成功地将强大的功能性、卓越的易用性和坚决的隐私保护结合于一身,这正是其能够在全球开发者社区中引发热潮的关键原因。它让本地大模型的交互和管理变得前所未有的简单和强大。

2 本地部署OpenWebUI

通过前面的演示和介绍,相信你已经对 OpenWebUI 的强大功能有了直观的认识。现在,让我们进入实战环节,一步步搭建属于你的专属 AI 工作台!

2.1 部署环境准备

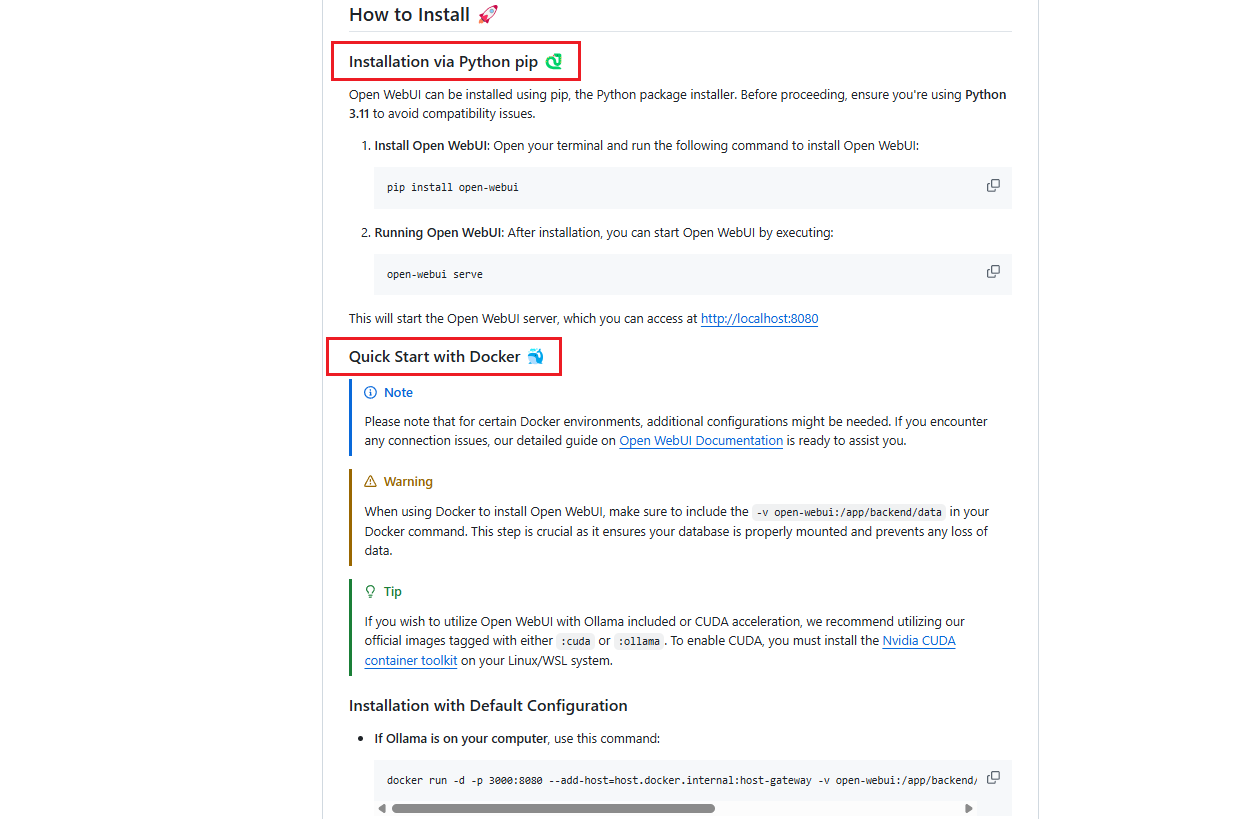

在开始部署之前,我们需要确保你的系统环境满足基本要求。OpenWebUI 支持多种部署方式,我们将重点介绍最推荐的 Python pip 部署方案,这种方式简单、快速且无需额外软件。

系统要求:

- Python 版本:Python 3.11(必须,其他版本可能有兼容性问题)

- 操作系统:Windows 10/11、macOS 10.15+、Linux (Ubuntu 18.04+、CentOS 7+)

- 内存:建议 8GB 以上(运行大模型需要更多内存)

- 存储空间:至少 10GB 可用空间(用于存储模型和数据库)

- 网络:需要网络连接以下载依赖包和模型

必需软件:

- Python 3.11:核心运行环境

- Ollama:本地大模型运行环境(可选,也可使用远程 API)

2.2 开始部署OpenWebUI

OpenWebUI 提供了多种部署方式,推荐使用Python pip 部署(强烈推荐)⭐,这是最简单、最快速的部署方式,只需要两条命令:

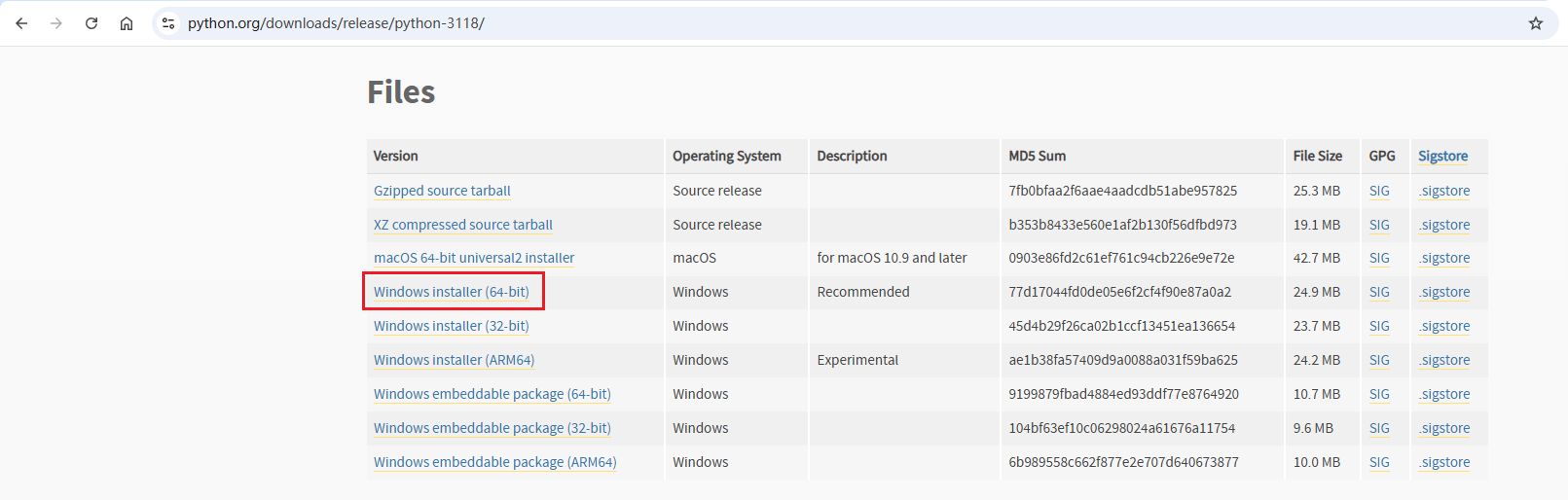

首先,确保您的电脑上拥有python 3.11版本的python环境,如果没有可以前往官方进行下载:

Python 3.11 下载地址及命令:

# Windows

https://www.python.org/downloads/release/python-3118/

# macOS

brew install python@3.11

# Linux (Ubuntu/Debian)

sudo apt install python3.11

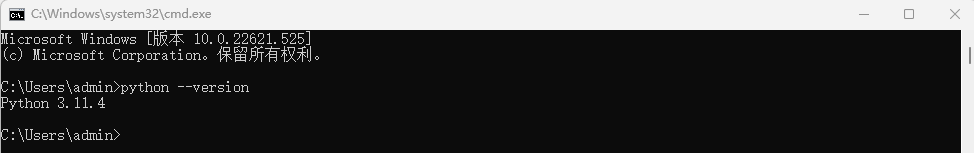

快速验证版本:

在cmd中输入如下命令进行验证版本:

python --version

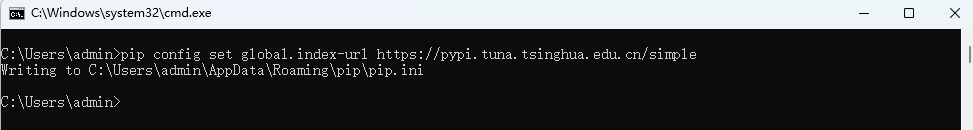

然后配置一下国内源镜像(用于加速下载依赖):

# 配置清华源加速下载

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

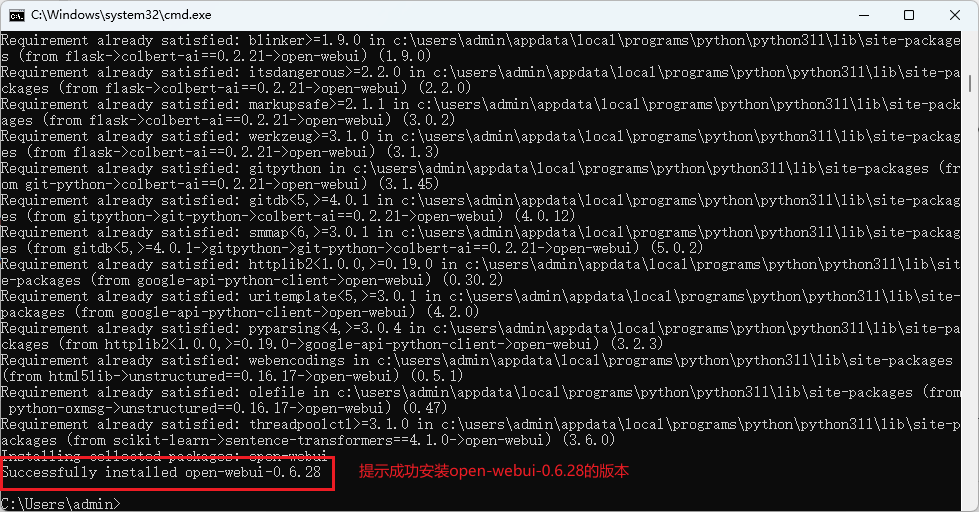

接下来,依旧在cmd中执行如下命令,进行安装OpenWebUI:

# 安装 OpenWebUI

pip install open-webui

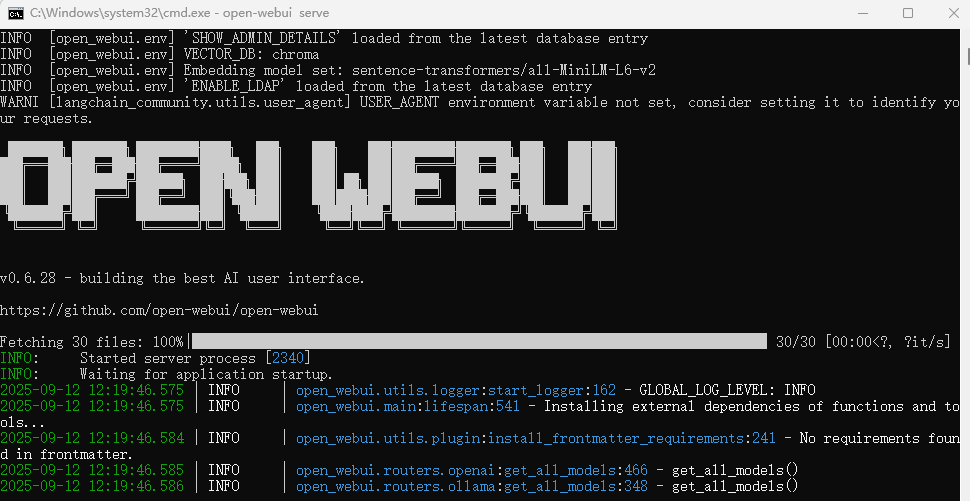

安装完成后,执行如下命令进行启动测试:

# 启动OpenWebUI

open-webui serve

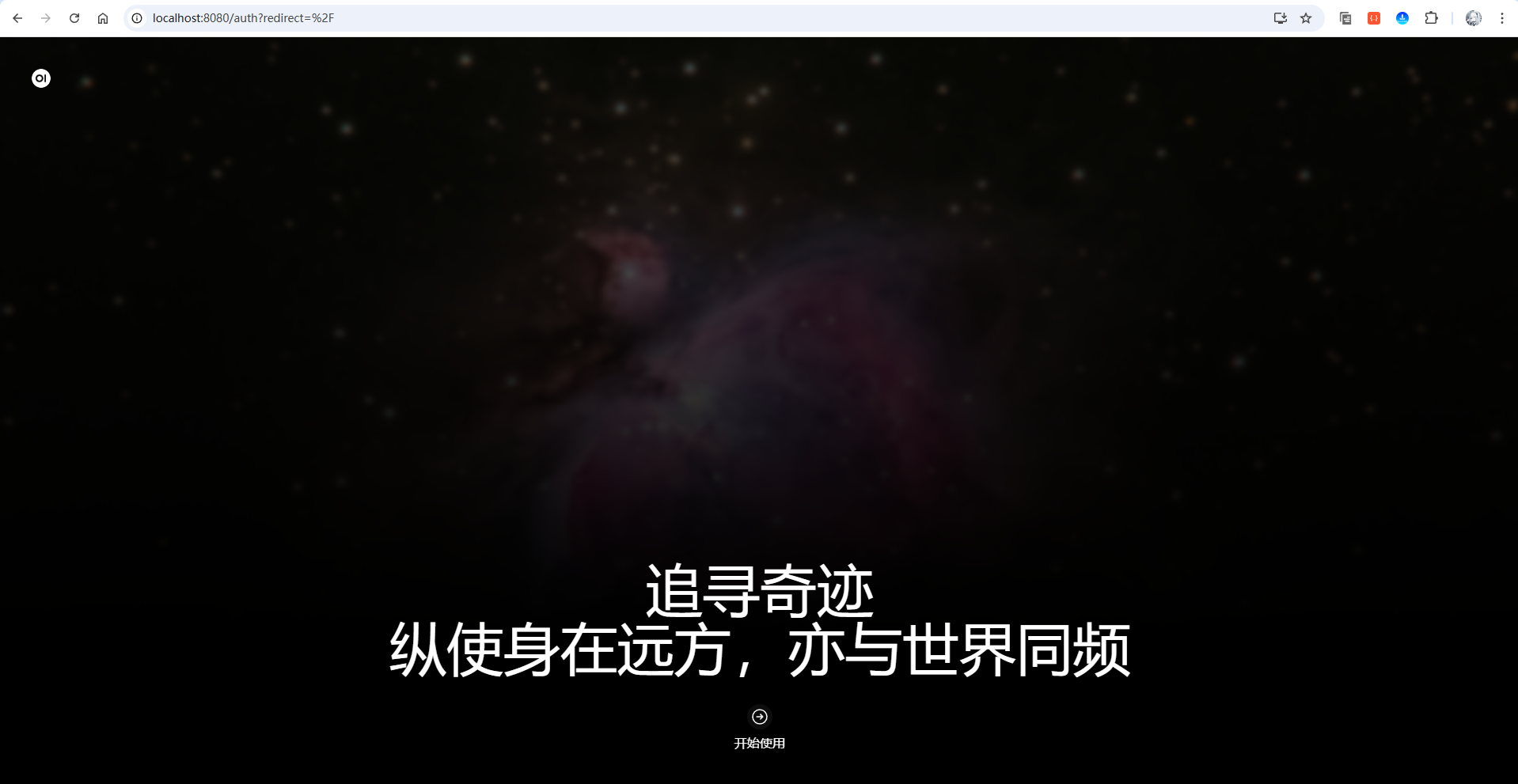

启动成功,让我们访问浏览器测试一下,请求如下网址,进行访问:

http://localhost:8080/

参考图如下:

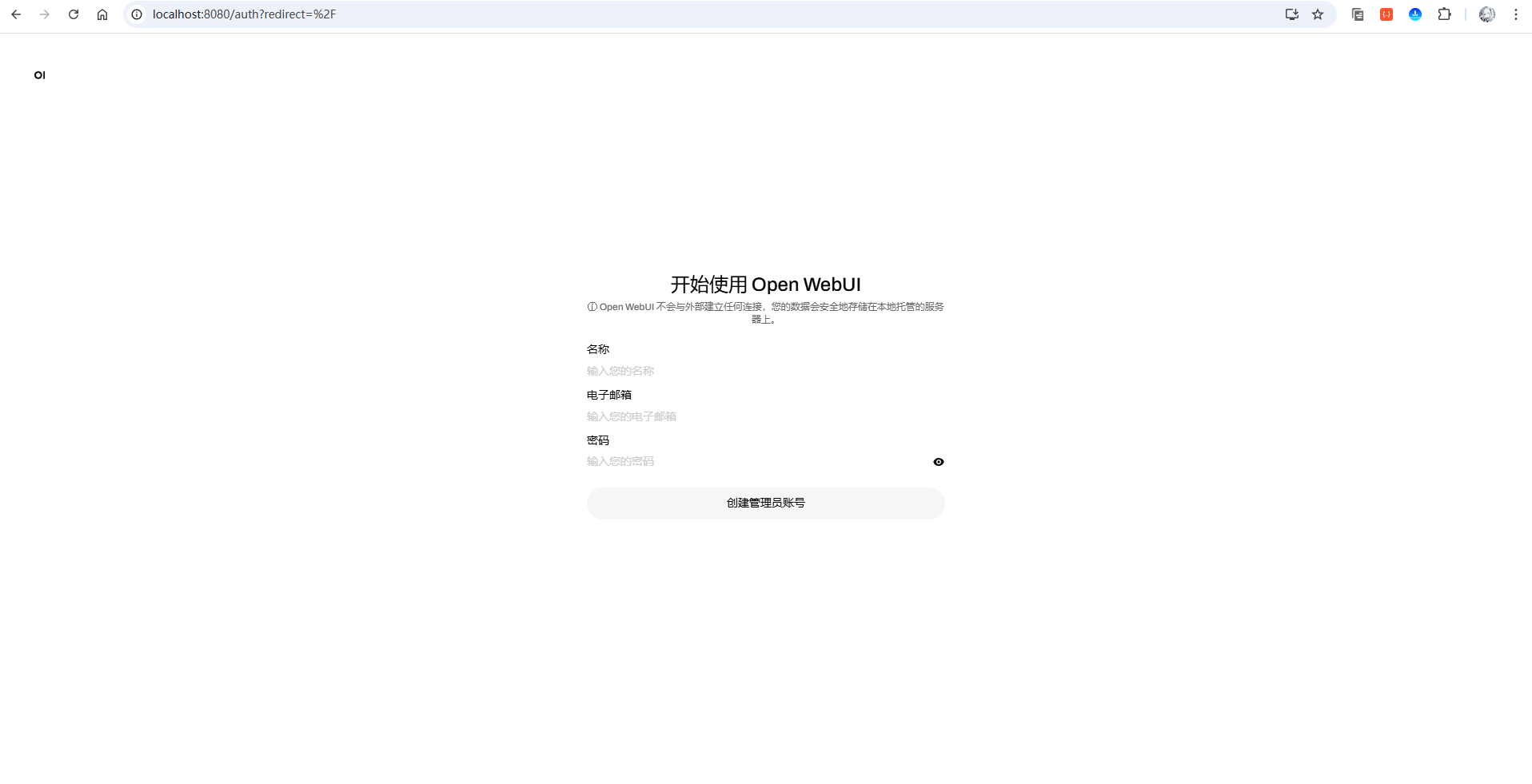

可以看到,成功的访问到了open web-ui的默认页面,接下来点击开始使用,进入到创建管理员账号页面:

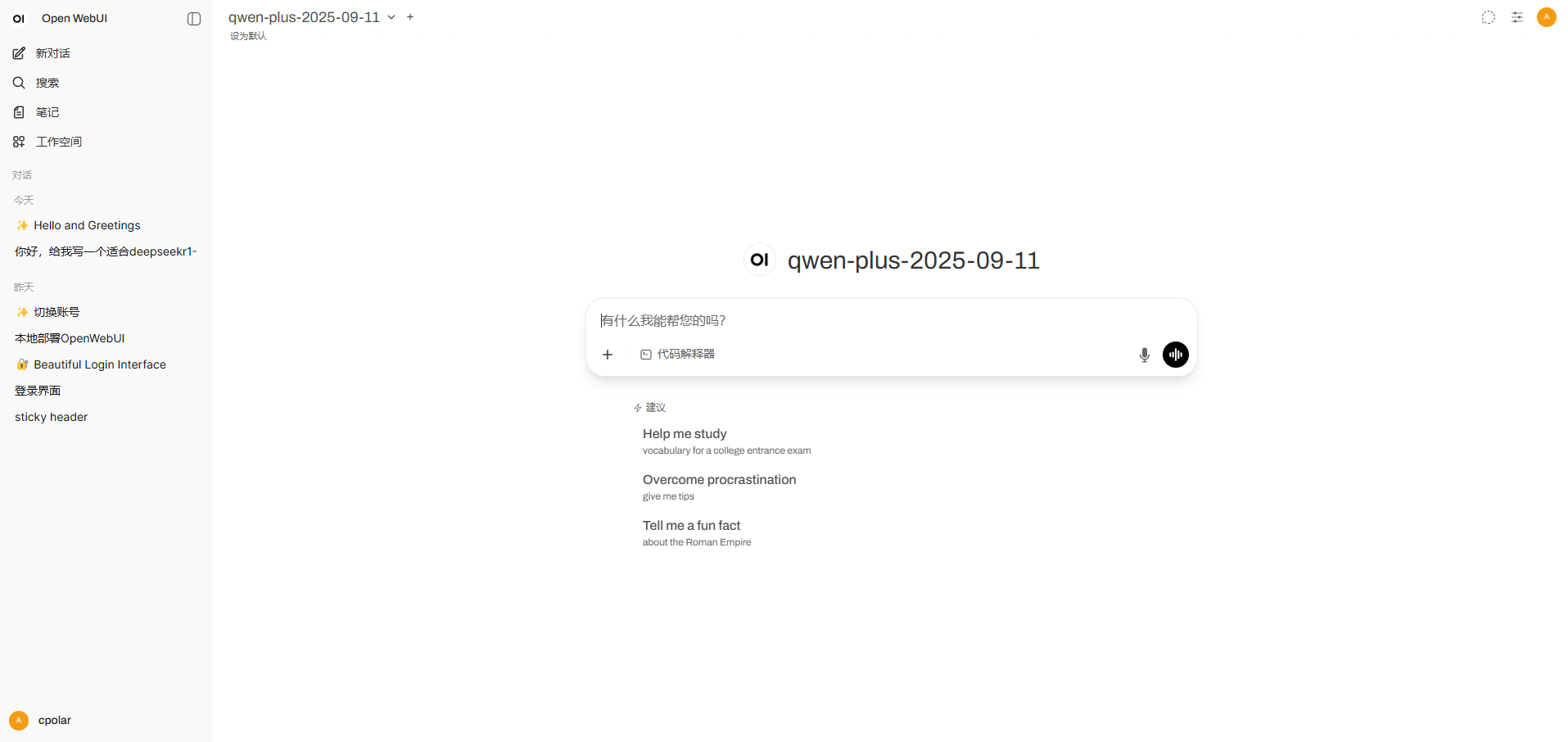

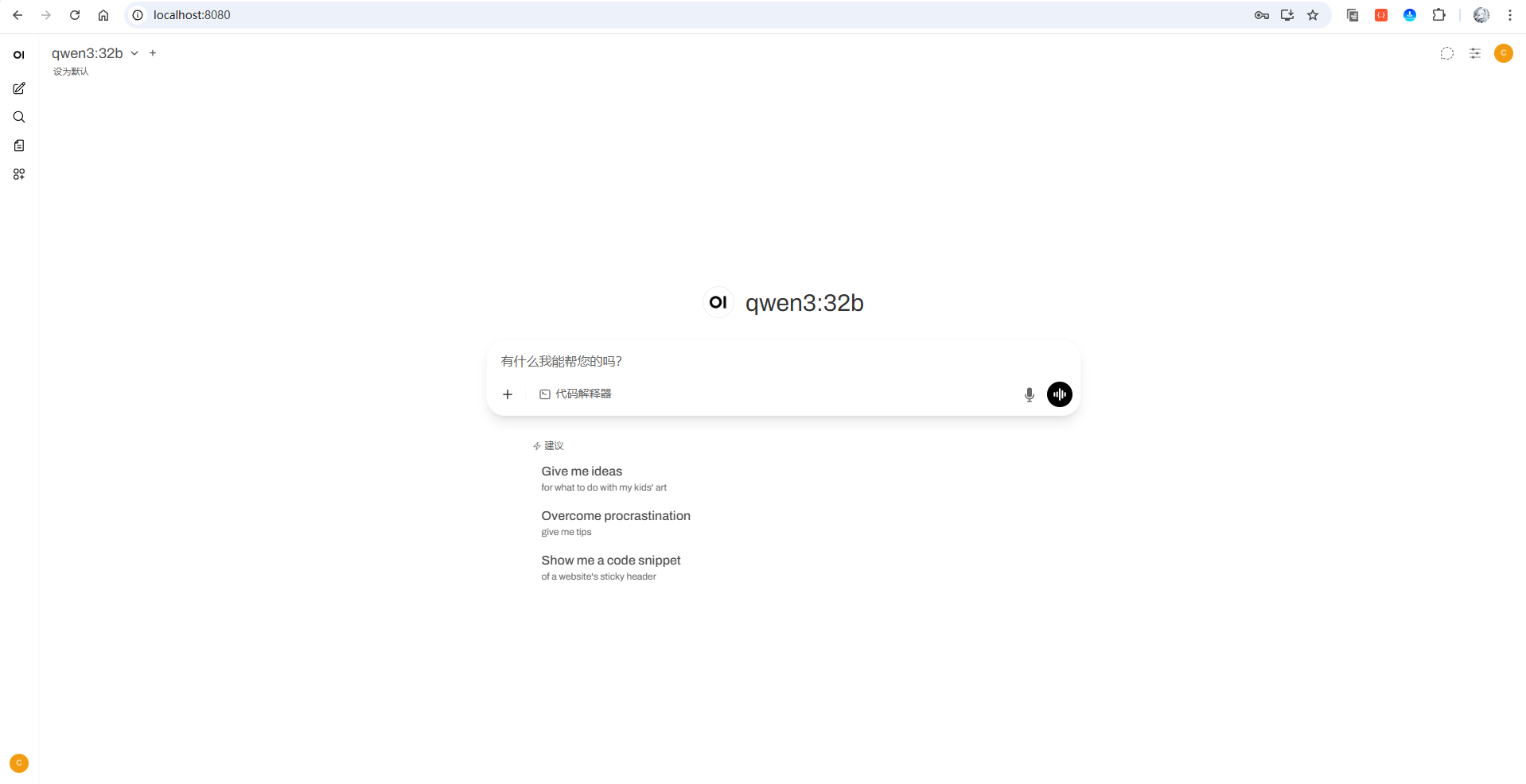

创建好您的管理员账号后,会自动登录进首页:

到这儿,您就已经初步成功的启动配置好您的 个人AI助理OpenWebUI啦,怎么样,是不是很简单!

3 配置接入DeepSeekR1-671B 大模型

3.1 接入DeepSeekR1- 671B(本地方案)

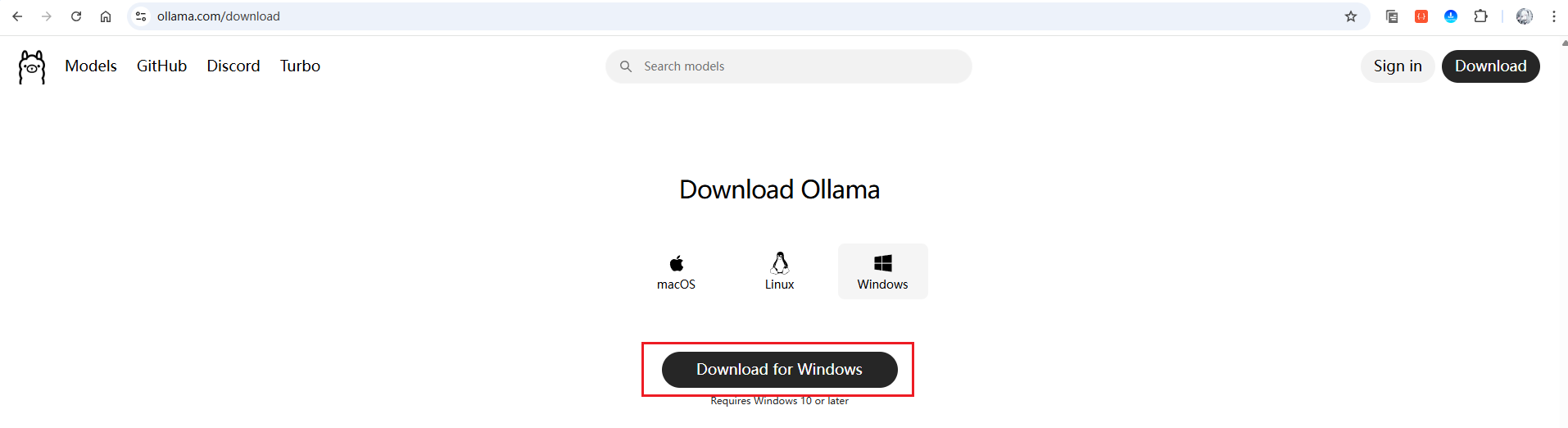

如果你要使用本地模型,需要先安装 Ollama服务,如果未进行安装,可以访问如下官方进行下载:

ollama官网下载地址:https://ollama.com/download

或者可使用如下命令进行安装:

# Windows

winget install Ollama.Ollama

# macOS

brew install ollama

# Linux

curl -fsSL https://ollama.ai/install.sh | sh

# 启动服务

ollama serve

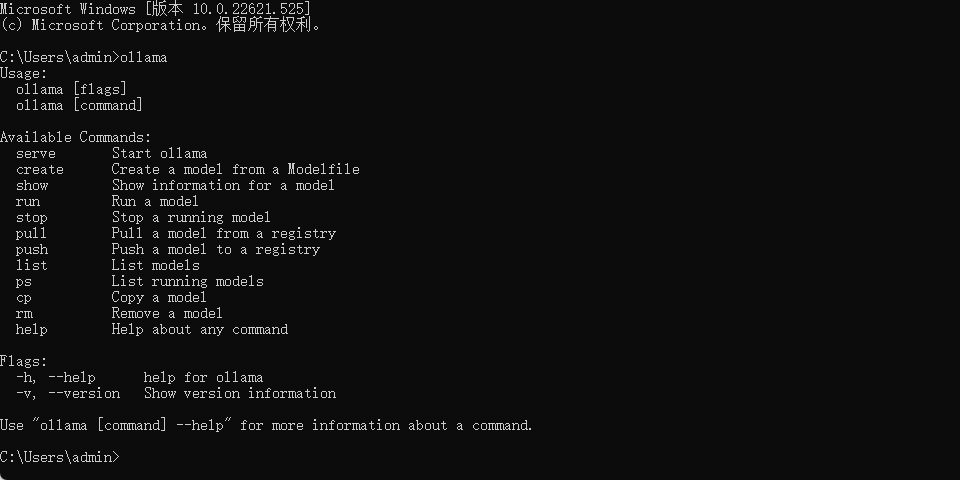

下载安装好后,可以在cmd中测试验证一下是否安装成功,直接输入如下命令:

ollama

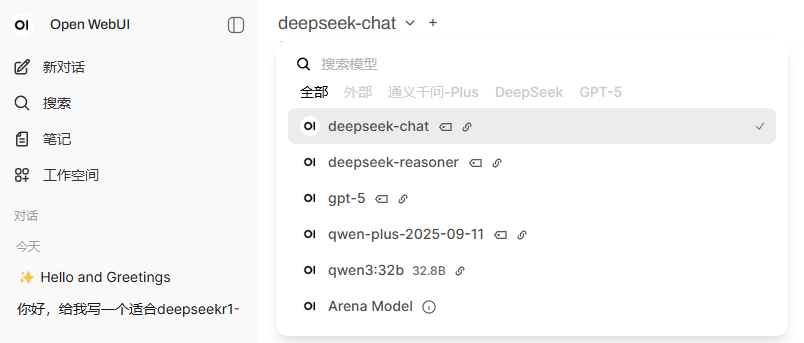

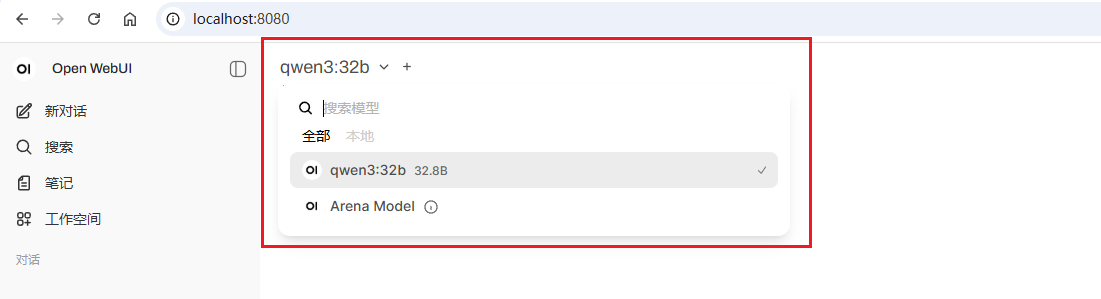

接下来,登录到OpenWebUI首页,进来以后,可以看到左上方的选择模型部分:

可以看到,我本地已经有一个qwen3:32b的模型,OpenWebUI帮我自动识别且添加进来了!

接下来,让我们再安装一个新的模型,进行演示,以deepseek-r1:1.5b为例(大概1.1G大小),在搜索模型中输入:

deepseek-r1:1.5b

然后点击从Ollama.com拉取“deepseek-r1:1.5B”的选项,就会进行自动下载该模型,参考如下GIF动图演示:

让我们测试一下和deepseek-r1:1.5B模型聊天对话(GIF动图演示-未加速):

可以看到,因为模型比较小,响应速度很快,且能够正常思考和回答问题!

接下来,演示一下接入本地部署了deepseek-r1:671B的ollama服务,让我们享受一下真正满血版的效果。

首先,点击左下角头像,然后在弹出来窗口点击设置,在接下来的弹出的窗口点击左下角的管理员设置,打开后台页面:

或者直接访问如下地址,也可以进入后台页面:

http://localhost:8080/admin/settings/general

后台页面:

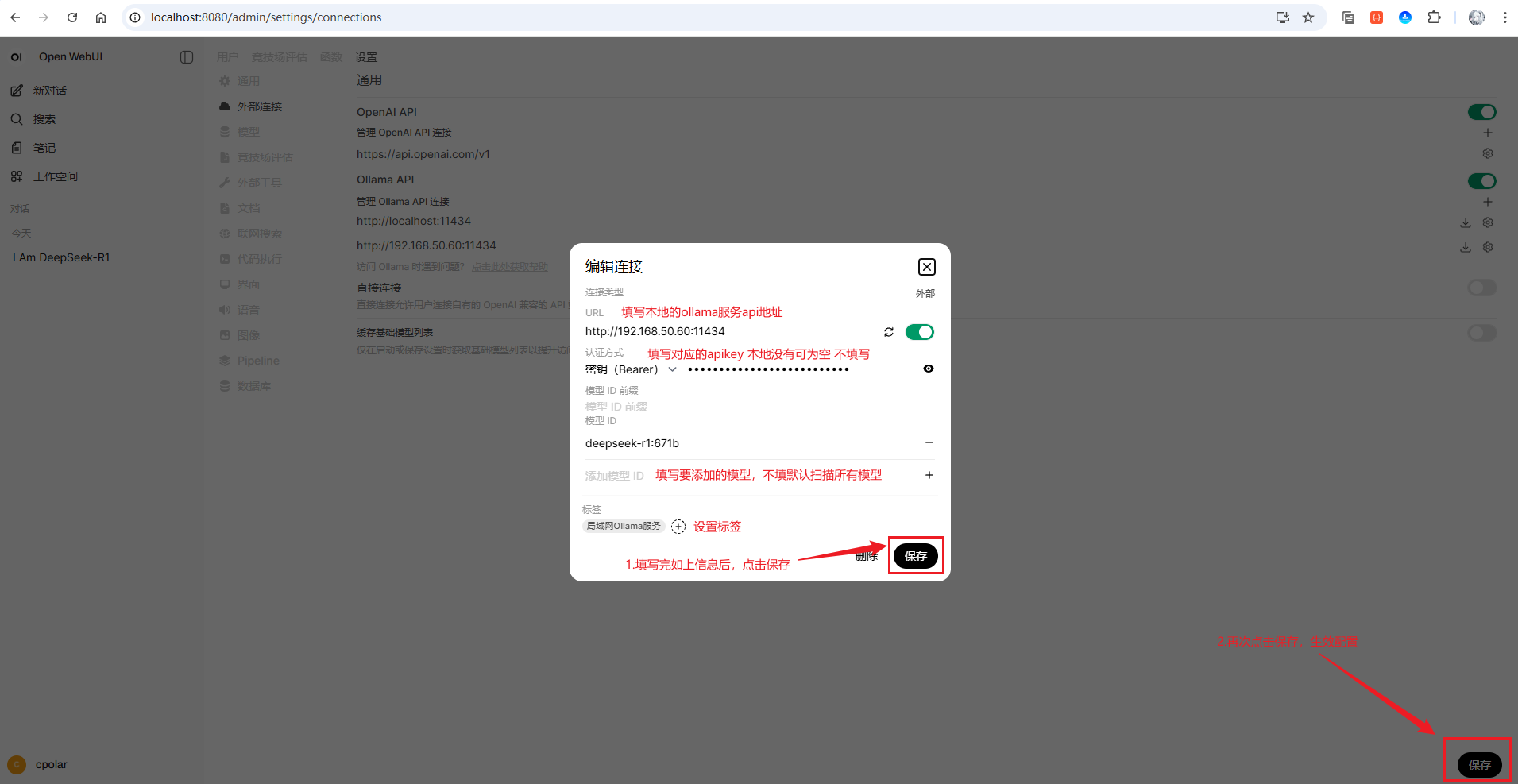

按照上图操作,依次点击外部连接,点击Ollama API右侧的+号按钮,在新弹出的添加连接窗口配置您的本地ollama服务:

回到首页,查看模型列表:

可以看到,成功的显示了接入来自局域网中ollama服务的deepseek-r1:671B大模型!

让我们演示一下是否可用(GIF动图参考):

可以看到,完美接入本地局域网中Ollama服务器中部署的满血版DeepSeekR1-671B大模型!和1.5B的模型对比差别巨大~

3.2 接入DeepSeekR1- 671B(Api方案)

在前面,我们已经部署接入了本地的Ollama服务,但是如果咱们的电脑没有办法跑这么大的模型怎么办呢?欸!别担心,我们可以使用线上的API服务,就不用借助我们本地的电脑来进行推理啦!有的小伙伴就有疑问了,用Api-key的方式不是收费的嘛?是的,使用Api-key的方式确实是收费的,但是阿里云百炼官方推出了一个重磅福利:新用户登录即可享受每个模型100万免费Tokens,参考图如下:

就以满血版的DeepSeekR1-671B大模型为例:

首先,咱们需要领取千问百万tokens,来到阿里云百炼官网,点击右上角新用户登录即享每个模型100万免费tokens:

阿里云百炼官网:

https://bailian.console.aliyun.com/#/home

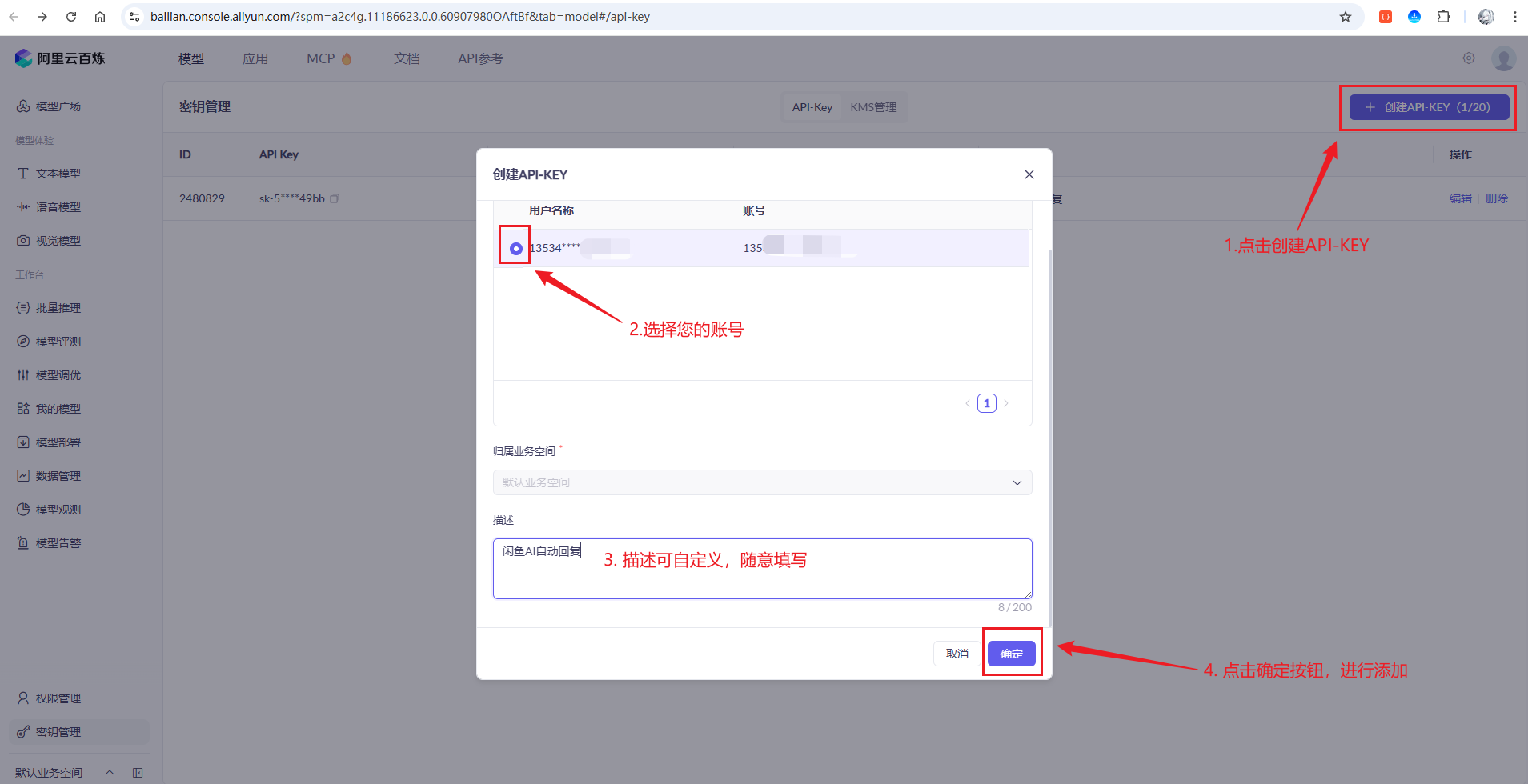

领取完成后,接下来进入密钥管理,设置设置千问api密钥:

密钥管理地址:

https://bailian.console.aliyun.com/?spm=a2c4g.11186623.0.0.60907980OAftBf&tab=model#/api-key

点击创建api-key,填写完信息:

然后点击复制按钮:

复制下来格式大概如下:

sk-53207f95f7e44ec18d05669767f649b7

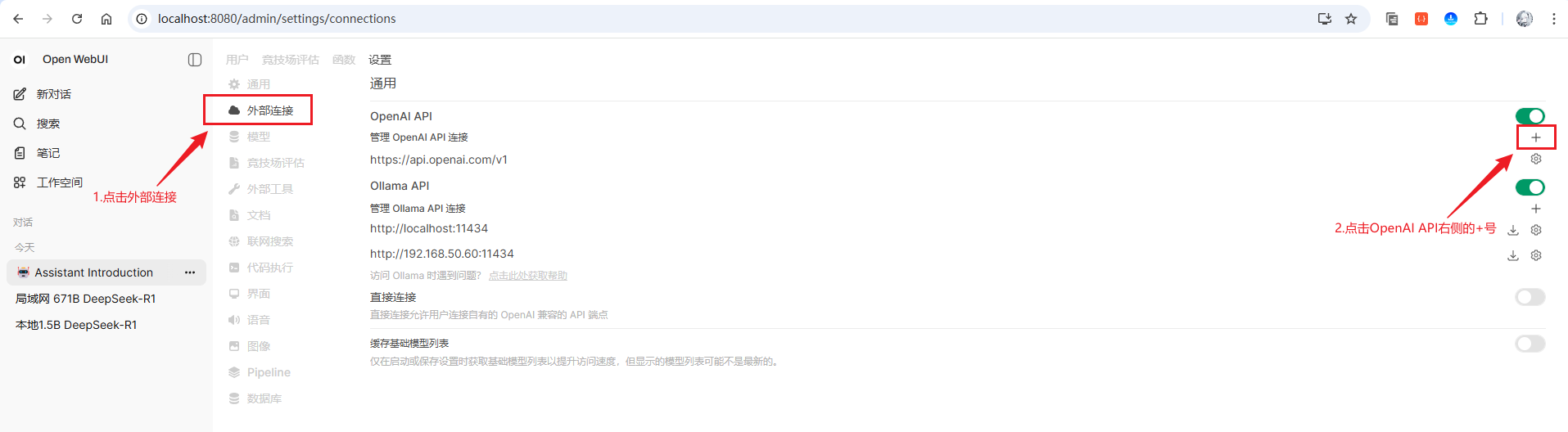

然后回到OpenWebUI首页.点击左下角头像,然后在弹出来窗口点击设置,在接下来的弹出的窗口点击左下角的管理员设置,打开后台页面:

或者直接访问如下地址,也可以进入后台页面:

http://localhost:8080/admin/settings/general

后台页面:

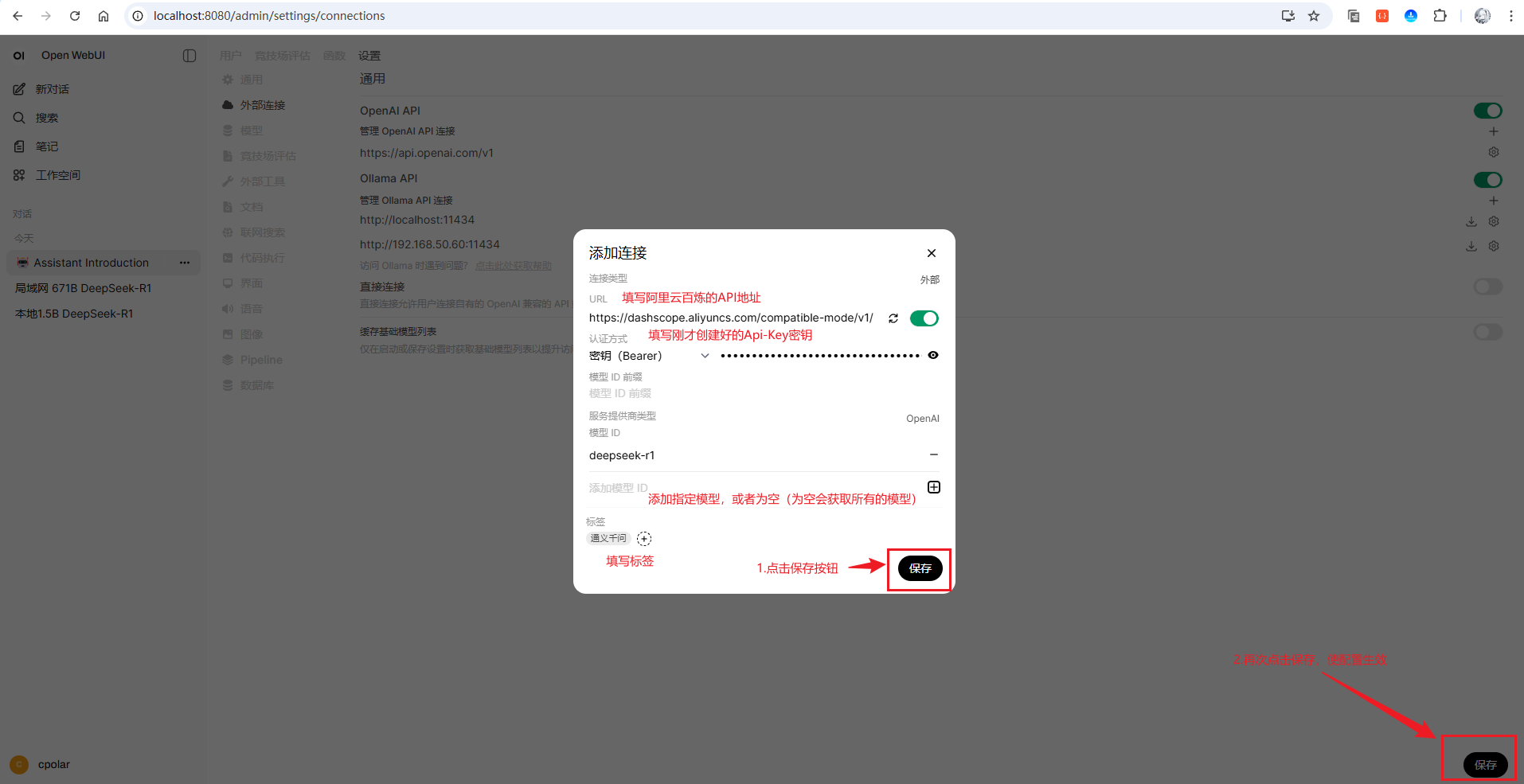

按照上图操作,依次点击外部连接,点击OpenAI API右侧的+号按钮,在新弹出的添加连接窗口配置您的阿里云百炼的服务:

# 阿里云百炼API地址

https://dashscope.aliyuncs.com/compatible-mode/v1/

配置参考图如下:

回到首页,点击查看标签为通义千问下的模型:

可以看到,成功的显示了接入来自阿里云百炼服务的deepseek-r1大模型!

让我们演示一下阿里云百炼服务的deepseek-r1大模型(GIF动图参考):

感觉怎么样,是不是超级简单?到这里,无论是本地的 Ollama 满血版 DeepSeek R1-671B,还是云端 API 方案,你都已在 OpenWebUI 中顺利接入、即开即用!

4 穿透OpenWebUI支持外网访问

通过前面的步骤,你已经成功搭建了一个功能强大的本地AI工作台。但是,你是否遇到过这样的困扰:当你在公司、咖啡厅或者出差时,想要访问家里的OpenWebUI来进行访问,却发现只能通过局域网访问?或者当朋友想要体验你的AI助手时,却因为网络限制而无法分享?这些场景正是内网穿透技术要解决的核心痛点。本章将带你使用cpolar内网穿透工具,让OpenWebUI突破局域网限制,实现全球任意地点的安全远程访问,真正实现”AI助手随身携带”的终极体验。

4.1 什么是cpolar?

- cpolar 是一款内网穿透工具,可以将你在局域网内运行的服务(如本地 Web 服务器、SSH、远程桌面等)通过一条安全加密的中间隧道映射至公网,让外部设备无需配置路由器即可访问。

- 广泛支持 Windows、macOS、Linux、树莓派、群晖 NAS 等平台,并提供一键安装脚本方便部署。

4.2 下载cpolar

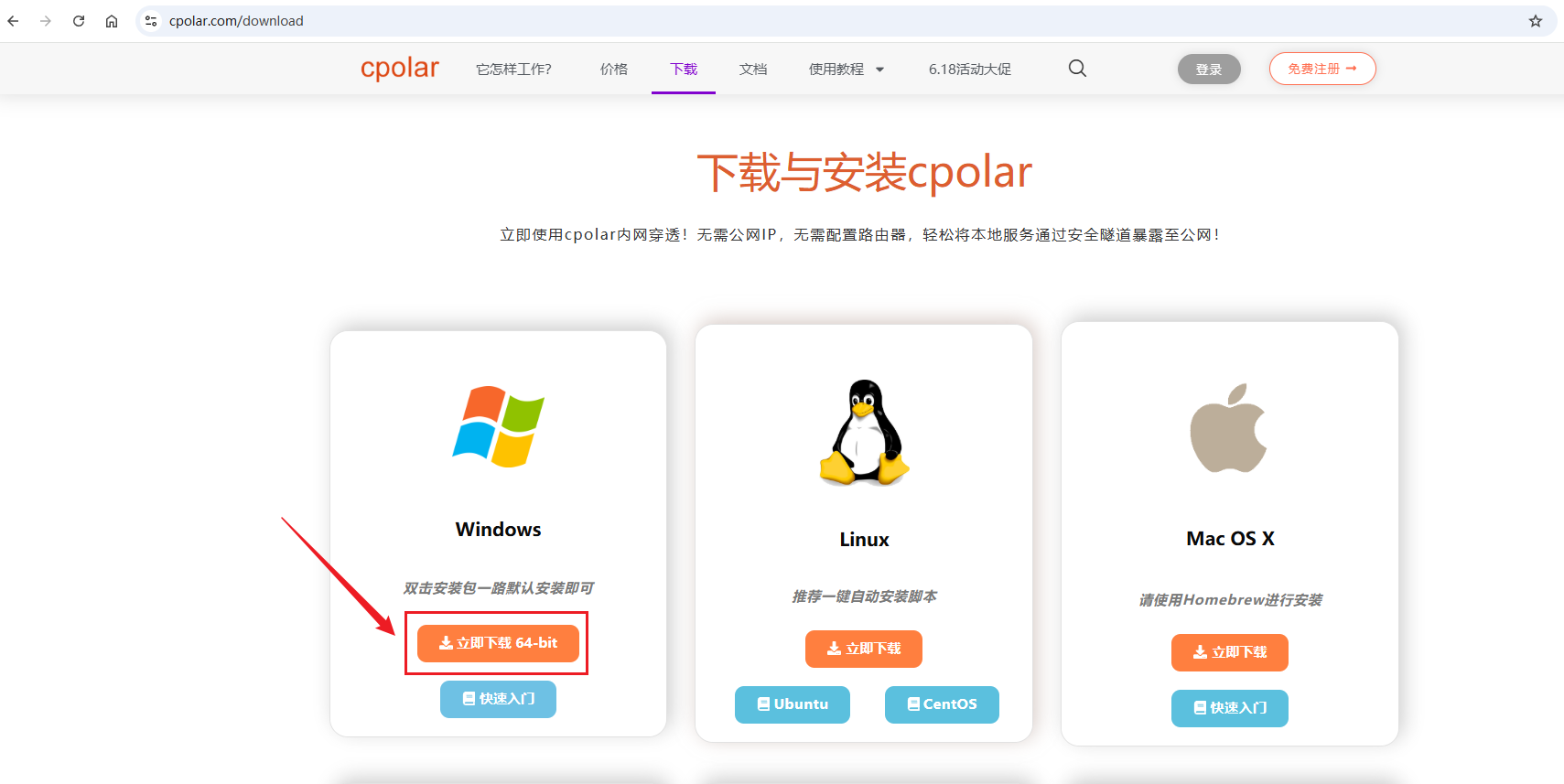

打开cpolar官网的下载页面:https://www.cpolar.com/download

点击立即下载 64-bit按钮,下载cpoalr的安装包:

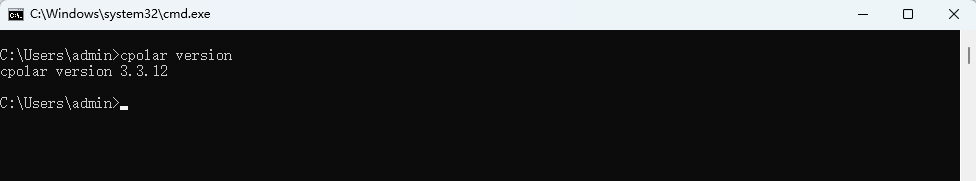

下来下来是一个压缩包,解压后执行目录种的应用程序,一路默认安装即可,安装完成后,打开cmd窗口输入如下命令确认安装:

cpolar version

出现如上版本即代表安装成功!

4.3 注册及登录cpolar web ui管理界面

4.3.1 注册cpolar

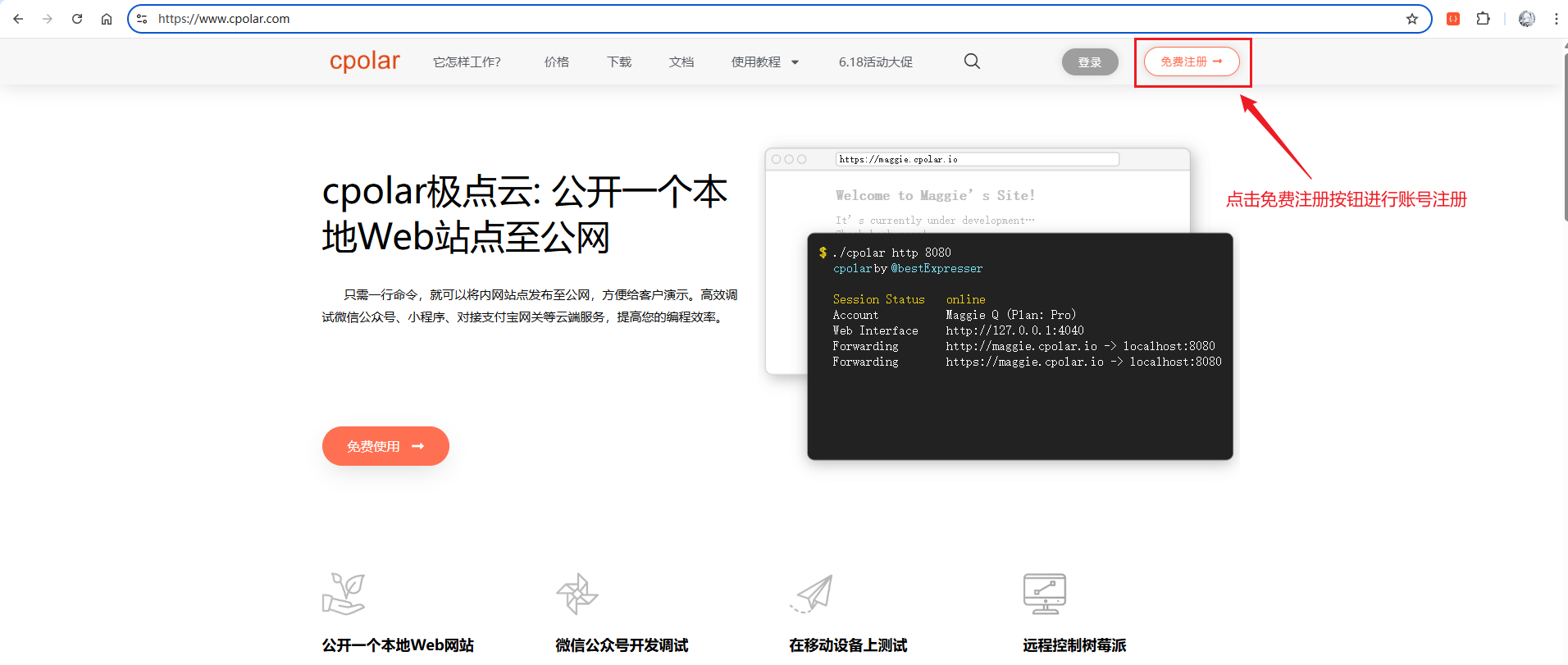

官网链接:https://www.cpolar.com/

访问cpolar官网,点击免费注册按钮,进行账号注册

进入到如下的注册页面进行账号注册:

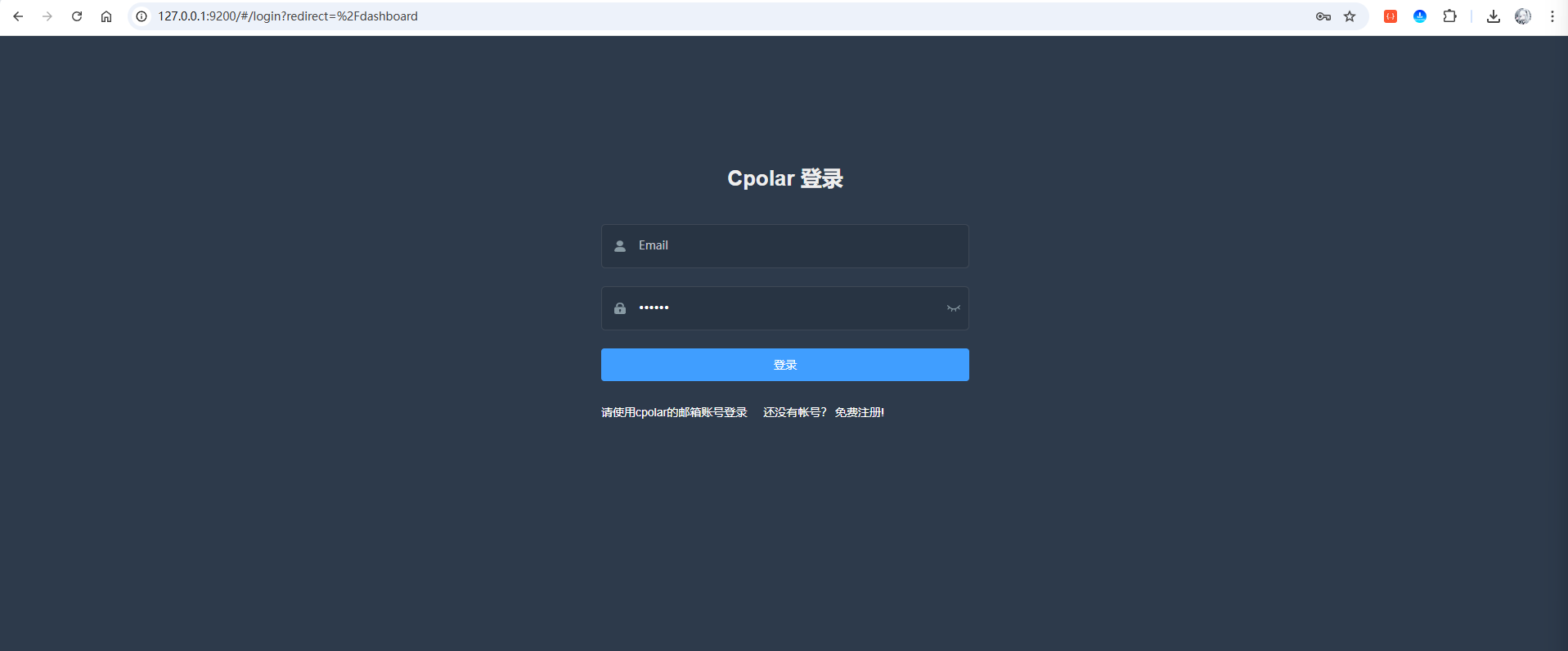

4.3.2 访问web ui管理界面

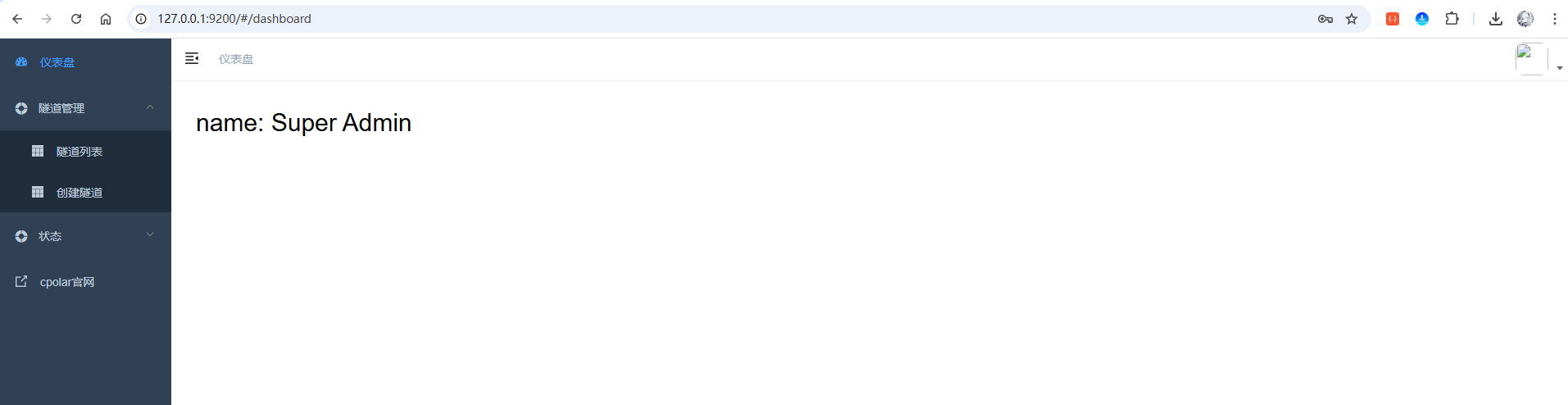

注册完成后,在浏览器中输入如下地址访问 web ui管理界面:

http://127.0.0.1:9200

输入刚才注册好的cpolar账号登录即可进入后台页面:

4.4 穿透OpenWebUI项目的WebUI界面

4.4.1 随机域名方式(免费方案)

随机域名方式适合预算有限的用户。使用此方式时,系统会每隔 24 小时 左右自动更换一次域名地址。对于长期访问的不太友好,但是该方案是免费的,如果您有一定的预算,可以查看大纲4.4.2 的固定域名方式,且访问更稳定。

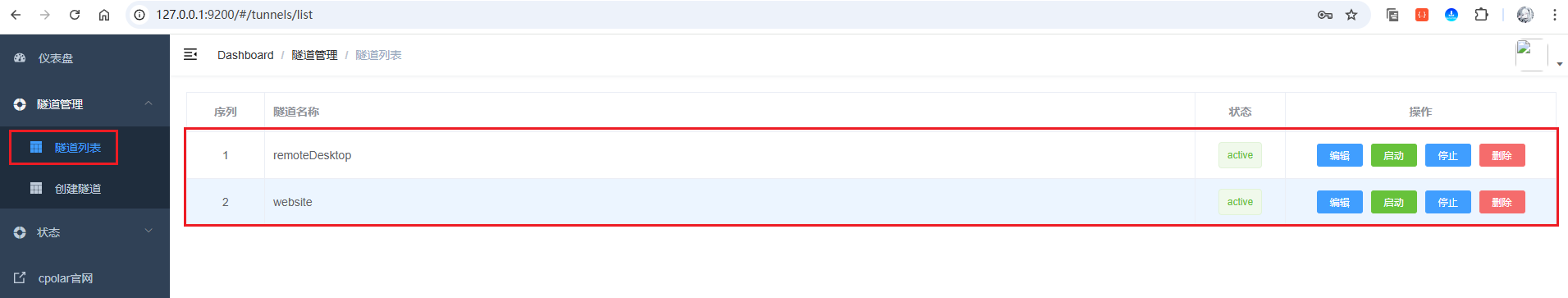

点击左侧菜单栏的隧道管理,展开进入隧道列表页面,页面下默认会有 2 个隧道:

- remoteDesktop隧道,指向3389端口,tcp协议

- website隧道,指向8080端口,http协议(http协议默认会生成2个公网地址,一个是http,另一个https,免去配置ssl证书的繁琐步骤)

点击编辑website的隧道,修改成我们open-webui需要的信息:

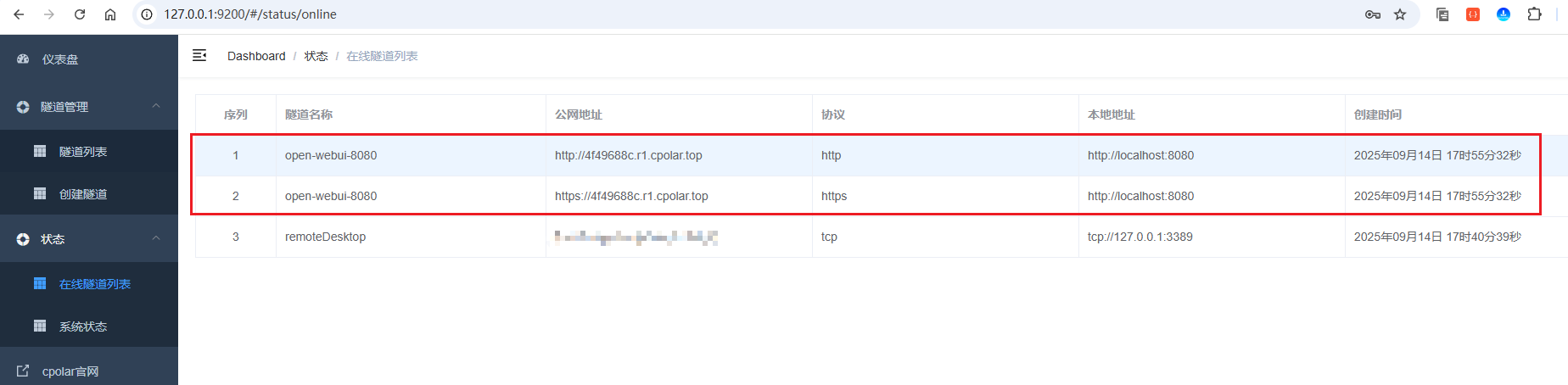

接着来到在线隧道列表,可以看到名称为open-webui-8080隧道的两条记录信息,一条协议为http,另一条协议为https:

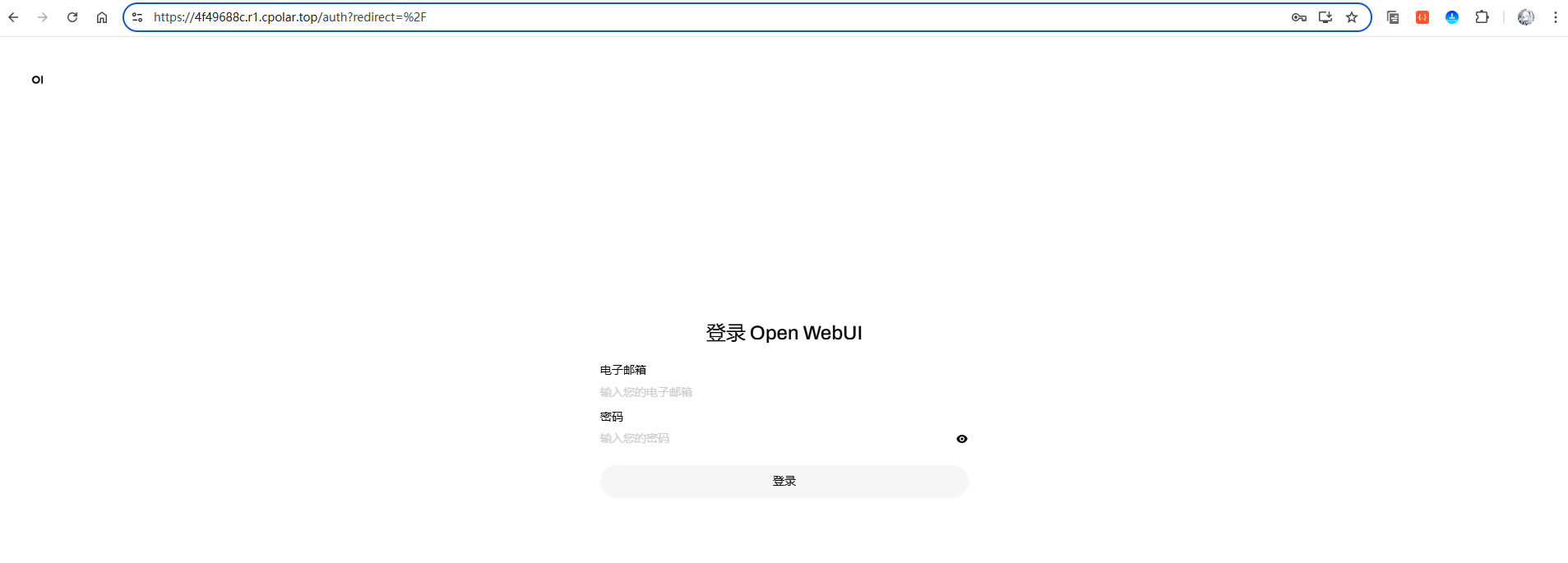

以https为例,访问测试(加载稍慢,需耐心等待一下):

可以看到,成功的访问到了open-webui的web页面了。恭喜!你已经成功实现了OpenWebUI的远程访问! 现在无论你身在何处,只要有网络就能随时访问你的专属AI工作台,真正实现了”AI助手随身携带”的终极体验。记得免费方案每24小时会更新域名地址,及时获取新地址即可持续享受远程访问的便利。

4.4.2 固定域名方式(升级任意套餐皆可)

通过前面的配置,我们已经成功实现了OpenWebUI的远程访问,但免费随机域名方案的局限性也逐渐显现:每24小时自动更换域名地址,意味着你需要频繁更新书签、重新分享链接,甚至可能因为忘记更新而无法访问。固定域名方案正是为了解决这些痛点而生,让你拥有一个永久不变的专属地址,真正实现稳定可靠的远程AI工作台。

好啦,接下来开始固定保留二级子域名教程!

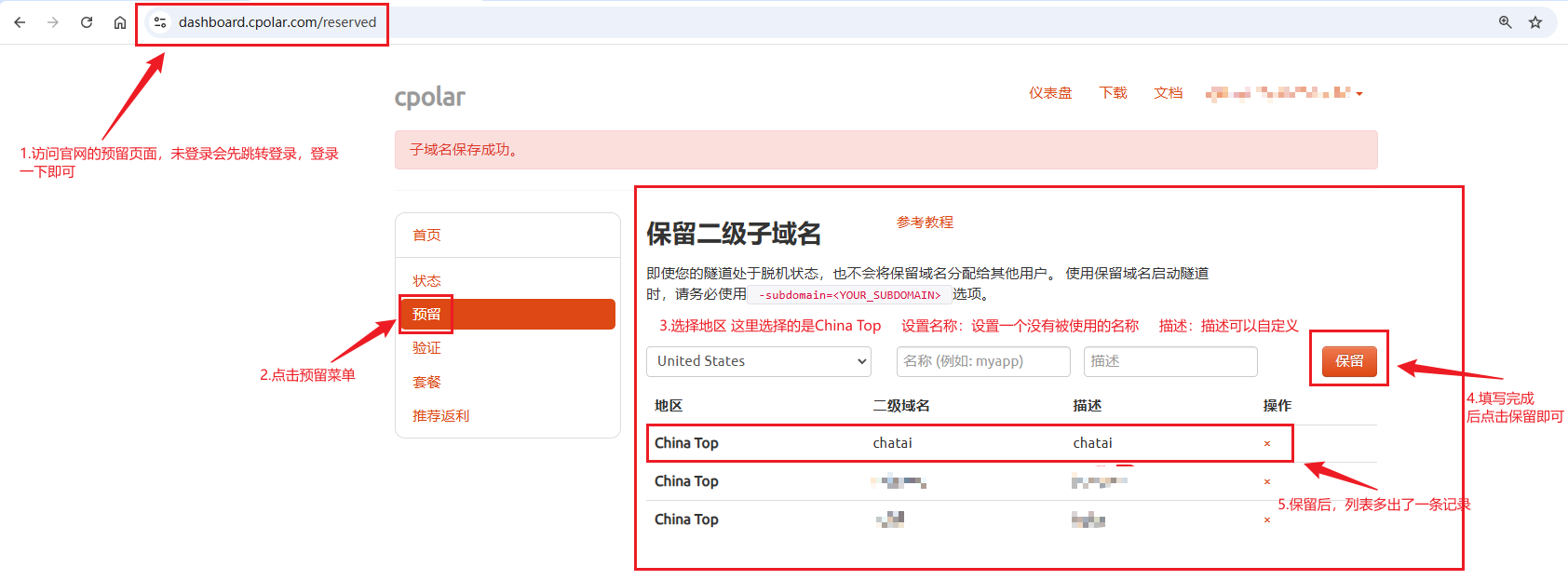

首先,进入官网的预留页面:

https://dashboard.cpolar.com/reserved

选择预留菜单,即可看到保留二级子域名项,填写其中的地区、名称、描述(可不填)项,然后点击保留按钮,操作步骤图如下:

列表中显示了一条已保留的二级子域名记录:

- 地区:显示为

China Top。 - 二级域名:显示为

chatai。

注:二级域名是唯一的,每个账号都不相同,请以自己设置的二级域名保留的为主

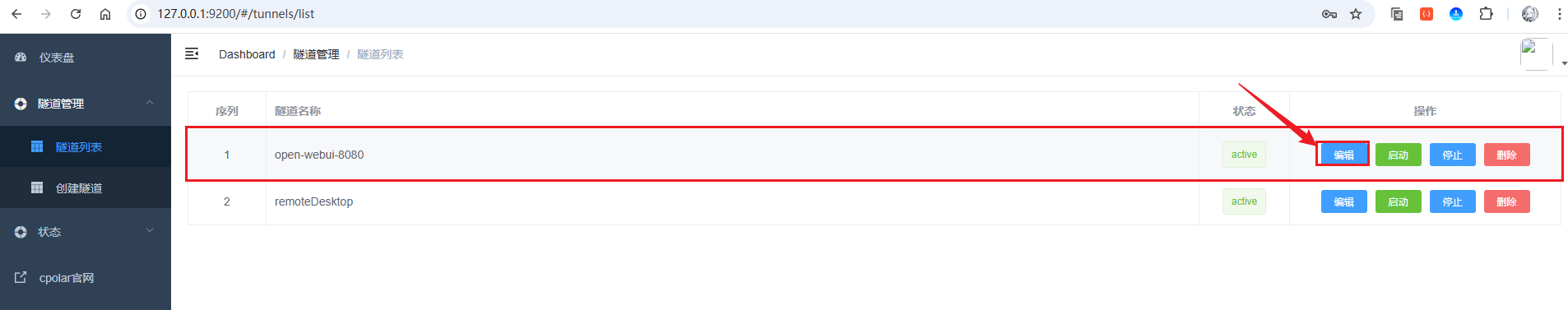

接着,进入侧边菜单栏的隧道管理下的隧道列表,可以看到名为open-webui-8080的隧道,点击编辑按钮进入编辑页面:

修改域名类型为二级子域名,然后填写前面配置好的子域名,点击更新按钮:

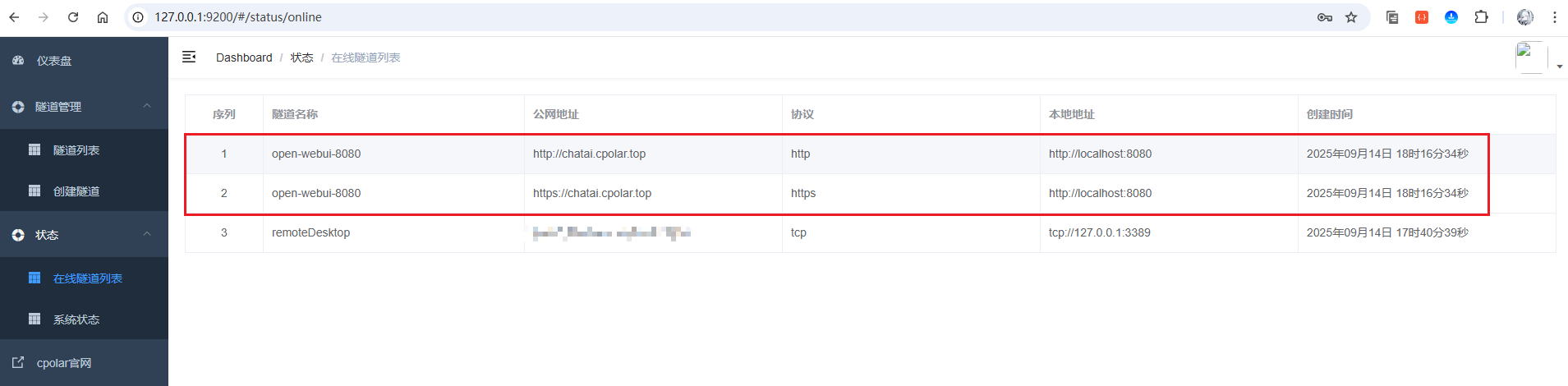

来到状态菜单下的在线隧道列表可以看到隧道名称为open-webui-8080的公网地址已经变更为二级子域名+固定域名主体及后缀的形式了:

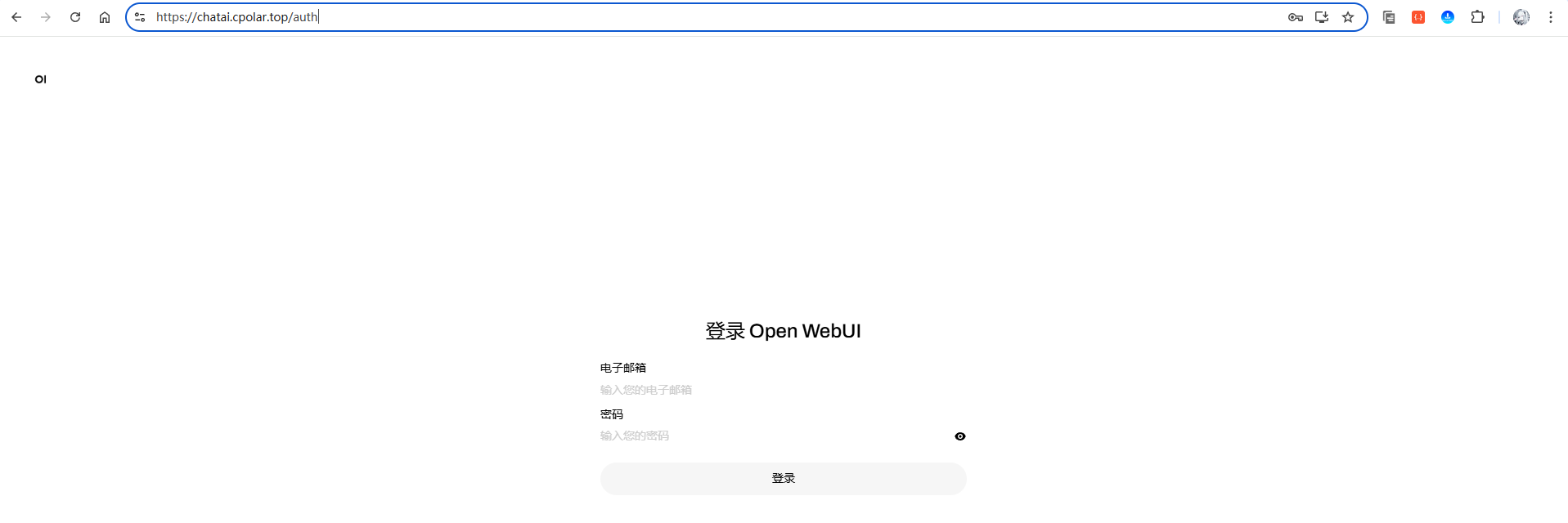

这里以https协议做访问测试(加载稍慢,需耐心等待一下):

访问成功!这样一来,你就拥有了一个永久不变的专属域名,再也不用担心24小时域名更换的问题。现在你可以将这个固定地址添加到浏览器书签,分享给同事朋友,甚至用于正式的生产环境。恭喜!你已经完成了从免费随机域名到固定域名的完美升级,真正实现了专业级的远程AI工作台部署!

总结

从命令行到可视化界面,从局域网到全球访问,从免费体验到专业部署——我们一步步将原本复杂的 AI 模型部署变成了人人都能上手的简单操作。OpenWebUI 的 110K Stars 不是偶然,它真正解决了”让 AI 好用”这个核心痛点。

- 告别命令行恐惧:从

ollama run到优雅的 Web 界面,让 AI 交互变得像使用 ChatGPT 一样简单 - 模型管理零门槛:本地 Ollama + 云端 API 双轨并行,1.5B 到 671B 模型随意切换

- 隐私与便利兼得:数据完全本地化,却又能全球访问,真正做到了”鱼和熊掌兼得”

- 从免费到专业:随机域名到固定域名,满足从个人体验到商业部署的全场景需求

- AI 能力边界扩展:RAG 知识库、工具调用、多用户协作,让 AI 不再是简单的聊天工具

这不仅仅是一个技术教程,更是一个完整的 AI 工作台解决方案。无论你是想体验最新的大模型,还是需要搭建企业级的 AI 平台,这套方案都能让你在几分钟内获得一个功能完整、安全可靠的 AI 助手。现在就开始,让你的 AI 之旅从这里启航!

感谢您阅读本篇文章,有任何问题欢迎留言交流。cpolar官网-安全的内网穿透工具 | 无需公网ip | 远程访问 | 搭建网站